背景

实践内容源于吴恩达老师与openAI合作推出的大语言模型教程,本教程基于面向开发者的LLM入门教程的golang版本实践(前两个章节)。

环境配置

1.申请OpenAI API Key

在OpenAI官网注册的账号默认有18美金的额度用于消耗token,3个月内有效。国内也有免费的内测Key供申请

https://github.com/chatanywhere/GPT_API_free,需要绑定Github账号来申请。

2.Golang tool库封装

封装一个CreateChatCompletion函数,放在同个package下引用

package main

import (

"context"

// 官方推荐的第三方OpenAl golang sdk

"github.com/sashabaranov/go-openai"

)

const (

Token = "<填入你的token>"

// 使用国内免费申请的Key的话,就用这个host用于转发请求

OpenAIProxyURL = "https://api.chatanywhere.com.cn/v1"

)

type openAIClient struct {

*openai.Client

}

func newOpenAIClient() *openAIClient {

config := openai.DefaultConfig(Token)

config.BaseURL = OpenAIProxyURL

c := openai.NewClientWithConfig(config)

return &openAIClient{c}

}

func (c *openAIClient) CreateChatCompletion(ctx context.Context, content string) (openai.ChatCompletionResponse, error) {

return c.Client.CreateChatCompletion(ctx, openai.ChatCompletionRequest{

Model: openai.GPT3Dot5Turbo,

Messages: []openai.ChatCompletionMessage{

{

Role: openai.ChatMessageRoleUser,

Content: content,

},

},

Temperature: 0,

})

}

面向开发者的提示工程

随着ChatGPT为代表的大语言大模型大爆发出现之后,Prompt已经成为与大模型输入的代称。一般将大模型的输入称为Prompt,将大模型的返回输出称为Completion。

合理的Prompt设计决定了大模型能力的上限和下限,学会充分、高效使用LLM,Prompt Engineering的技能强烈需要。Prompt Engineering是针对特定任务构造充分

发挥大模型能力的Prompt的技巧。

简介Introduction

随着LLM的发展,大致分为两种类型:

- 基础LLM:基于文本训练数据,训练出预测下一个单词能力的模型。通常通过在互联网和其他来源的大量数据上训练,来确定紧接着出现的最可能的词。

- 指令微调LLM:通过专门的训练,可以更好地理解并遵循指令。指令微调LLM的训练通常基于预训练语言模型,先在大规模文本数据上进行预训练,掌握语言的基本规律。 在此基础上进行进一步的训练与微调(finetune),输入是指令,输出是对这些指令的正确回复。还可以通过RLHF(人类反馈强化学习)技术,增强模型的能力。

这里的实践重点介绍针对指令微调LLM的最佳实践。

提示原则Guidelines

高效Prompt的两个关键原则:

- 编写清晰、具体的指令;清晰明确地表达需求,提供足够的上下文,让大语言模型准确理解需求。

- 给予模型充足思考时间;加入逐步推理的要求,给模型留充分思考时间,生成的结果更准确可靠。

掌握这两个关键原则,是大语言模型成功的重要基石。

编写清晰具体的指令

使用分隔符

分隔符可以将不同的指令、上下文、输入隔开,防止提示词注入,输入的文本可能包含与预设的Prompt冲突的内容,如果不加分隔,这些输入可能扰乱模型的输出。

示例:给出一段话,让GPT进行总结,使用"“作为分隔符

func main() {

text := `

您应该提供尽可能清晰、具体的指示,以表达您希望模型执行的任务。\

这将引导模型朝向所需的输出,并降低收到无关或不正确响应的可能性。\

不要将写清晰的提示词与写简短的提示词混淆。\

在许多情况下,更长的提示词可以为模型提供更多的清晰度和上下文信息,从而导致更详细和相关的输出。

`

prompt := `

把用两个双引号括起来的文本总结成一句话。

"%s"

`

client := newOpenAIClient()

resp, err := client.CreateChatCompletion(context.TODO(), fmt.Sprintf(prompt, text))

if err != nil {

fmt.Printf("ChatCompletion error: %v\n", err)

return

}

fmt.Println(resp.Choices[0].Message.Content)

}

输出:

提供清晰、具体的指示可以引导模型朝向所需的输出,避免无关或不正确的响应。长度更长的提示词可以提供更多的清晰度和上下文信息,导致更详细和相关的输出。

结构化输出

结构化输出,指的是类似json、html等结构。

示例:让GPT生成三本书的标题、作者和类别,并以JSON格式返回,其中JSON的key已指定

func main() {

prompt := `

请生成包括书名、作者和类别的三本虚构的、非真实存在的中文书籍清单,\

并以JSON格式提供,其中包含以下键:book_id、title、author、genre。

`

client := newOpenAIClient()

resp, err := client.CreateChatCompletion(context.TODO(), prompt)

if err != nil {

fmt.Printf("ChatCompletion error: %v\n", err)

return

}

fmt.Println(resp.Choices[0].Message.Content)

}

输出:

[

{

"book_id": 1,

"title": "夜色旅人",

"author": "张三",

"genre": "奇幻"

},

{

"book_id": 2,

"title": "梦境之城",

"author": "李四",

"genre": "科幻"

},

{

"book_id": 3,

"title": "幻想之门",

"author": "王五",

"genre": "魔幻"

}

]

模型检查

如果任务包含不一定能满足的条件,可以让模型检查这些条件,如果不满足,可以让其停止执行后续的流程。可以加入一些边界情况的考虑,以避免意外的结果或错误发生。

示例:分别给模型两段文本,一是制作茶的步骤,二是一段没有明确步骤的文本。要求模型判断是否其包含一系列指令,包含则按照给定格式重新编写指令,不包含则返回"未提供步骤”

// 制作茶的步骤

func main() {

text1 := `

泡一杯茶很容易。首先,需要把水烧开。\

在等待期间,拿一个杯子并把茶包放进去。\

一旦水足够热,就把它倒在茶包上。\

等待一会儿,让茶叶浸泡。几分钟后,取出茶包。\

如果您愿意,可以加一些糖或牛奶调味。\

就这样,您可以享受一杯美味的茶了。

`

prompt := `

您将获得由两个双引号括起来的文本。\

如果它包含一系列的指令,则需要按照以下格式重新编写这些指令:

第一步 - ...

第二步 - …

…

第N步 - …

如果文本中不包含一系列的指令,则直接写“未提供步骤”。

"%s"

`

client := newOpenAIClient()

resp, err := client.CreateChatCompletion(context.TODO(), fmt.Sprintf(prompt, text1))

if err != nil {

fmt.Printf("ChatCompletion error: %v\n", err)

return

}

fmt.Println(resp.Choices[0].Message.Content)

}

输出:

第一步 - 把水烧开。

第二步 - 拿一个杯子并把茶包放进去。

第三步 - 把热水倒在茶包上。

第四步 - 等待几分钟让茶叶浸泡,然后取出茶包。

第五步 - 可以选择加入糖或牛奶调味。

第六步 - 就这样,您可以享受一杯美味的茶了。

// 一段没有明确步骤的文本

func main() {

text2 := `

泡一杯茶很容易。首先,需要把水烧开。\

在等待期间,拿一个杯子并把茶包放进去。\

一旦水足够热,就把它倒在茶包上。\

等待一会儿,让茶叶浸泡。几分钟后,取出茶包。\

如果您愿意,可以加一些糖或牛奶调味。\

就这样,您可以享受一杯美味的茶了。

`

prompt := `

您将获得由两个双引号括起来的文本。\

如果它包含一系列的指令,则需要按照以下格式重新编写这些指令:

第一步 - ...

第二步 - …

…

第N步 - …

如果文本中不包含一系列的指令,则直接写“未提供步骤”。

"%s"

`

client := newOpenAIClient()

resp, err := client.CreateChatCompletion(context.TODO(), fmt.Sprintf(prompt, text2))

if err != nil {

fmt.Printf("ChatCompletion error: %v\n", err)

return

}

fmt.Println(resp.Choices[0].Message.Content)

}

输出:

未提供步骤

提供少量示例

Few-shot prompting,在模型执行具体任务之前,给模型1~2个样例,让模型了解要求和期望输出的样式

示例:利用少量样例,可以预热语言模型,这是一个让模型快速上手新任务的有效策略。

func main() {

prompt := `

您的任务是以一致的风格回答问题。

<孩子>: 请教我何为耐心。

<祖父母>: 挖出最深峡谷的河流源于一处不起眼的泉眼;最宏伟的交响乐从单一的音符开始;最复杂的挂毯以一根孤独的线开始编织。

<孩子>: 请教我何为韧性。

`

client := newOpenAIClient()

resp, err := client.CreateChatCompletion(context.TODO(), prompt)

if err != nil {

fmt.Printf("ChatCompletion error: %v\n", err)

return

}

fmt.Println(resp.Choices[0].Message.Content)

}

输出:

<祖父母>: 韧性就像一根弹簧,能够在压力和挑战面前保持弹性和坚韧。它是一种适应和持久的能力,能够在困的本质。

给模型时间思考

给模型充足的时间思考,可以提高模型的准确性,好比让一个人在短时间内去解决一个非常棘手的问题,难度可见之大。

指定完成任务的步骤

示例:描述了杰克和吉尔的故事,并给出提示词执行以下操作:首先,用一句话概括三个反引号限定的文本。第二,将摘要翻译成英语。第三,在英语摘要中列出每个名称。 第四,输出包含以下键的JSON对象:英语摘要和人名个数。要求输出以换行符分隔

func main() {

text := `

在一个迷人的村庄里,兄妹杰克和吉尔出发去一个山顶井里打水。\

他们一边唱着欢乐的歌,一边往上爬,\

然而不幸降临——杰克绊了一块石头,从山上滚了下来,吉尔紧随其后。\

虽然略有些摔伤,但他们还是回到了温馨的家中。\

尽管出了这样的意外,他们的冒险精神依然没有减弱,继续充满愉悦地探索。

`

prompt := `

执行以下操作:

1-用一句话概括下面用两个双反引号括起来的文本。

2-将摘要翻译成英语。

3-在英语摘要中列出每个人名。

4-输出一个 JSON 对象,其中包含以下键:english_summary,num_names。

请用换行符分隔您的答案。

"%s"

`

client := newOpenAIClient()

resp, err := client.CreateChatCompletion(context.TODO(), fmt.Sprintf(prompt, text))

if err != nil {

fmt.Printf("ChatCompletion error: %v\n", err)

return

}

fmt.Println(resp.Choices[0].Message.Content)

}

输出:

1- 兄妹在迷人的村庄冒险后受伤但仍然乐观。

2- Siblings Jack and Jill set off to fetch water from a well on a mountaintop in a charming village.

3- Jack, Jill

4- {

"english_summary": "Siblings Jack and Jill set off to fetch water from a well on a mountaintop in a charming village. Despite getting injured in an unfortunate accident, they still maintained their adventurous spirit and continued to explore joyfully.",

"num_names": 2

}

可以将prompt改进,确切指定输出格式

func main() {

text := `

在一个迷人的村庄里,兄妹杰克和吉尔出发去一个山顶井里打水。\

他们一边唱着欢乐的歌,一边往上爬,\

然而不幸降临——杰克绊了一块石头,从山上滚了下来,吉尔紧随其后。\

虽然略有些摔伤,但他们还是回到了温馨的家中。\

尽管出了这样的意外,他们的冒险精神依然没有减弱,继续充满愉悦地探索。

`

prompt := `

1-用一句话概括下面用双引号括起来的文本。

2-将摘要翻译成英语。

3-在英语摘要中列出每个名称。

4-输出一个 JSON 对象,其中包含以下键:English_summary,num_names。

请使用以下格式:

文本:<要总结的文本>

摘要:<摘要>

翻译:<摘要的翻译>

名称:<英语摘要中的名称列表>

输出 JSON:<带有 English_summary 和 num_names 的 JSON>

"%s"

`

client := newOpenAIClient()

resp, err := client.CreateChatCompletion(context.TODO(), fmt.Sprintf(prompt, text))

if err != nil {

fmt.Printf("ChatCompletion error: %v\n", err)

return

}

fmt.Println(resp.Choices[0].Message.Content)

}

输出:

摘要:故事讲述了杰克和吉尔在山顶井打水时发生意外,但他们的冒险精神依然没有减弱。

翻译:Summary: The story tells about an accident that happened to Jack and Jill while they were geng water from a well on the mountaintop, but their adventurous spirit remained undiminished.

名称:Jack, Jill

输出 JSON:{"English_summary": "The story tells about an accident that happened to Jack and Jill we they were getting water from a well on the mountaintop, but their adventurous spirit remained undiminished.", "num_names": 2}

指导模型自主思考

设计prompt时,可以通过明确指导语言模型进行自主思考。在prompt中要求语言模型先自己尝试解决问题,思考对应的解决方法,再与提供的解答进行对比,校验正确性。

示例:给出一个问题和一份来自学生的解答,要求模型判断解答是否正确

func main() {

prompt := `

判断学生的解决方案是否正确。

问题:

我正在建造一个太阳能发电站,需要帮助计算财务。

土地费用为 100美元/平方英尺

我可以以 250美元/平方英尺的价格购买太阳能电池板

我已经谈判好了维护合同,每年需要支付固定的10万美元,并额外支付每平方英尺10美元

作为平方英尺数的函数,首年运营的总费用是多少。

学生的解决方案:

设x为发电站的大小,单位为平方英尺。

费用:

土地费用:100x

太阳能电池板费用:250x

维护费用:100,000美元+100x

总费用:100x+250x+100,000美元+100x=450x+100,000美元

`

client := newOpenAIClient()

resp, err := client.CreateChatCompletion(context.TODO(), prompt)

if err != nil {

fmt.Printf("ChatCompletion error: %v\n", err)

return

}

fmt.Println(resp.Choices[0].Message.Content)

}

输出:

学生的解决方案是正确的。总费用可以表示为450x+100,000美元。

实际上这个解决方案是错误的,总费用应该是360x+100,000美元,因为没让模型自行先计算,然后跟学生的解决方法对比,那么就有可能误导模型以为学生的解法就是正确的。 接下来调整思路,让模型先自行解决这个问题,再根据自己的解法跟学生的解法进行对比,然后再判断学生的解法是否正确。

func main() {

prompt := `

请判断学生的解决方案是否正确,请通过如下步骤解决这个问题:

步骤:

首先,自己解决问题。

然后将您的解决方案与学生的解决方案进行比较,对比计算得到的总费用与学生计算的总费用是否一致,并评估学生的解决方案是否正确。

在自己完成问题之前,请勿决定学生的解决方案是否正确。

使用以下格式:

问题:问题文本

学生的解决方案:学生的解决方案文本

实际解决方案和步骤:实际解决方案和步骤文本

学生计算的总费用:学生计算得到的总费用

实际计算的总费用:实际计算出的总费用

学生计算的费用和实际计算的费用是否相同:是或否

学生的解决方案和实际解决方案是否相同:是或否

学生的成绩:正确或不正确

问题:

我正在建造一个太阳能发电站,需要帮助计算财务。

- 土地费用为每平方英尺100美元

- 我可以以每平方英尺250美元的价格购买太阳能电池板

- 我已经谈判好了维护合同,每年需要支付固定的10万美元,并额外支付每平方英尺10美元;

作为平方英尺数的函数,首年运营的总费用是多少。

学生的解决方案:

设x为发电站的大小,单位为平方英尺。

费用:

1. 土地费用:100x美元

2. 太阳能电池板费用:250x美元

3. 维护费用:100,000+100x=10万美元+10x美元

总费用:100x美元+250x美元+10万美元+100x美元=450x+10万美元

实际解决方案和步骤:

`

client := newOpenAIClient()

resp, err := client.CreateChatCompletion(context.TODO(), prompt)

if err != nil {

fmt.Printf("ChatCompletion error: %v\n", err)

return

}

fmt.Println(resp.Choices[0].Message.Content)

}

输出:

首先,我们需要计算土地费用、太阳能电池板费用和维护费用的总和。

土地费用:100美元/平方英尺 * x平方英尺 = 100x美元

太阳能电池板费用:250美元/平方英尺 * x平方英尺 = 250x美元

维护费用:10万美元 + 10美元/平方英尺 * x平方英尺 = 10万美元 + 10x美元

总费用:100x美元 + 250x美元 + 10万美元 + 10x美元 = 360x + 10万美元

学生计算的总费用:450x + 10万美元

实际计算的总费用:360x + 10万美元

学生计算的费用和实际计算的费用是否相同:否

学生的解决方案和实际解决方案是否相同:否

学生的成绩:不正确

局限性

模型偶尔会生成一些看似真实,实际上不存在的知识。模型经过大量预训练,虽然掌握了丰富知识,但是难以判断自己的知识边界,可能会做出错误推断。这个现象称为幻觉(Hallucination), 是语言模型的一大陷阱。

func main() {

prompt := `

告诉我华为公司生产的GT Watch运动手表的相关信息

`

client := newOpenAIClient()

resp, err := client.CreateChatCompletion(context.TODO(), prompt)

if err != nil {

fmt.Printf("ChatCompletion error: %v\n", err)

return

}

fmt.Println(resp.Choices[0].Message.Content)

}

输出:

华为公司生产的GT Watch运动手表是一款运动智能手表,具有多项健康功能和运动追踪功能,如心率监测、睡眠 Watch还支持多种运动模式,包括跑步、骑行、游泳等,

可全面监测和分析用户的运动数据。此外,GT Watch还观,适合运动和日常佩戴。

可以通过Prompt设计减少幻觉的发生,比如让语言模型直接引用文本中的原句,然后再进行解答。语言模型的幻觉问题事关应用的可靠性与安全性。,采取prompt优化措施可以缓解,这也是未来语言模型 进化的重要方向之一。

英文原版Prompt

1.1 使用分隔符隔离不同输入部分

func main() {

text := `

You should express what you want a model to do by \

providing instructions that are as clear and \

specific as you can possibly make them. \

This will guide the model towards the desired output, \

and reduce the chances of receiving irrelevant \

or incorrect responses. Don't confuse writing a \

clear prompt with writing a short prompt. \

In many cases, longer prompts provide more clarity \

and context for the model, which can lead to \

more detailed and relevant outputs.

`

prompt := `

Summarize the text delimited by two double quotes \

into a single sentence.

"%s"

`

client := newOpenAIClient()

resp, err := client.CreateChatCompletion(context.TODO(), fmt.Sprintf(prompt, text))

if err != nil {

fmt.Printf("ChatCompletion error: %v\n", err)

return

}

fmt.Println(resp.Choices[0].Message.Content)

}

输出:

Clear and specific instructions for a model will guide it towards the desired output, reducing the chances of irrelevant or incorrect responses,

and longer prompts can provide more clarity and context, leading to more detailed and relevant outputs.

1.2 结构化输出

func main() {

prompt := `

Generate a list of three made-up book titles along \

with their authors and genres.

Provide them in JSON format with the following keys:

book_id, title, author, genre.

`

client := newOpenAIClient()

resp, err := client.CreateChatCompletion(context.TODO(), prompt)

if err != nil {

fmt.Printf("ChatCompletion error: %v\n", err)

return

}

fmt.Println(resp.Choices[0].Message.Content)

}

输出:

{

"books": [

{

"book_id": 1,

"title": "The Forgotten Symphony",

"author": "Madeline Harper",

"genre": "Mystery"

},

{

"book_id": 2,

"title": "Echoes of Eternity",

"author": "Jackson Pierce",

"genre": "Science Fiction"

},

{

"book_id": 3,

"title": "The Enchanted Garden",

"author": "Sophie Evans",

"genre": "Fantasy"

}

]

}

1.3 模型检查是否满足条件

func main() {

text1 := `

Making a cup of tea is easy! First, you need to get some \

water boiling. While that's happening, \

grab a cup and put a tea bag in it. Once the water is \

hot enough, just pour it over the tea bag. \

Let it sit for a bit so the tea can steep. After a \

few minutes, take out the tea bag. If you \

like, you can add some sugar or milk to taste. \

And that's it! You've got yourself a delicious \

cup of tea to enjoy.

`

prompt := `

You will be provided with text delimited by two double quotes.

If it contains a sequence of instructions, \

re-write those instructions in the following format:

Step 1 - ...

Step 2 - …

…

Step N - …

If the text does not contain a sequence of instructions, \

then simply write \"No steps provided.

"%s"

`

client := newOpenAIClient()

resp, err := client.CreateChatCompletion(context.TODO(), fmt.Sprintf(prompt, text1))

if err != nil {

fmt.Printf("ChatCompletion error: %v\n", err)

return

}

fmt.Println(resp.Choices[0].Message.Content)

}

输出:

Step 1 - Get some water boiling.

Step 2 - Grab a cup and put a tea bag in it.

Step 3 - Pour hot water over the tea bag.

Step 4 - Let the tea steep for a few minutes.

Step 5 - Remove the tea bag.

Step 6 - Add sugar or milk to taste.

func main() {

text2 := `

The sun is shining brightly today, and the birds are \

singing. It's a beautiful day to go for a \

walk in the park. The flowers are blooming, and the \

trees are swaying gently in the breeze. People \

are out and about, enjoying the lovely weather. \

Some are having picnics, while others are playing \

games or simply relaxing on the grass. It's a \

perfect day to spend time outdoors and appreciate the \

beauty of nature.

`

prompt := `

You will be provided with text delimited by two double quotes.

If it contains a sequence of instructions, \

re-write those instructions in the following format:

Step 1 - ...

Step 2 - …

…

Step N - …

If the text does not contain a sequence of instructions, \

then simply write \"No steps provided.

"%s"

`

client := newOpenAIClient()

resp, err := client.CreateChatCompletion(context.TODO(), fmt.Sprintf(prompt, text2))

if err != nil {

fmt.Printf("ChatCompletion error: %v\n", err)

return

}

fmt.Println(resp.Choices[0].Message.Content)

}

输出:

No steps provided.

1.4 提供少量示例

func main() {

prompt := `

Your task is to answer in a consistent style.

<child>: Teach me about patience.

<grandparent>: The river that carves the deepest \

valley flows from a modest spring; the \

grandest symphony originates from a single note; \

the most intricate tapestry begins with a solitary thread.

<child>: Teach me about resilience.

`

client := newOpenAIClient()

resp, err := client.CreateChatCompletion(context.TODO(), prompt)

if err != nil {

fmt.Printf("ChatCompletion error: %v\n", err)

return

}

fmt.Println(resp.Choices[0].Message.Content)

}

输出:

<grandparent>: Resilience is like the mighty oak that withstands the strongest of storms, bending but never breaking. It is the spirit that rises from adversity, the strength that perseveres in the face of challenges. Like the phoenix that rises from the ashes, resilience is the ability to bounce back and thrive, no matter the circumstances.

2.1 指定完成任务所需的步骤

func main() {

text := `

In a charming village, siblings Jack and Jill set out on \

a quest to fetch water from a hilltop \

well. As they climbed, singing joyfully, misfortune \

struck—Jack tripped on a stone and tumbled \

down the hill, with Jill following suit. \

Though slightly battered, the pair returned home to \

comforting embraces. Despite the mishap, \

their adventurous spirits remained undimmed, and they \

continued exploring with delight.

`

prompt1 := `

Perform the following actions:

1 - Summarize the following text delimited by two double \

backticks with 1 sentence.

2 - Translate the summary into French.

3 - List each name in the French summary.

4 - Output a json object that contains the following \

keys: french_summary, num_names.

Separate your answers with line breaks.

Text:

"%s"

`

client := newOpenAIClient()

resp, err := client.CreateChatCompletion(context.TODO(), fmt.Sprintf(prompt1, text))

if err != nil {

fmt.Printf("ChatCompletion error: %v\n", err)

return

}

fmt.Println("Completion for prompt 1: \n", resp.Choices[0].Message.Content)

}

输出:

Completion for prompt 1:

1 - Jack and Jill, despite a mishap on their quest for water, returned home with adventurous spirits undimmed.

2 - Jack et Jill, malgré un accident dans leur quête d'eau, sont rentrés chez eux avec des esprits aventureux intacts.

3 - Jack, Jill

4 -

{

"french_summary": "Jack et Jill, malgré un accident dans leur quête d'eau, sont rentrés chez eux avec des esprits aventureux intacts.",

"num_names": 2

}

func main() {

text := `

In a charming village, siblings Jack and Jill set out on \

a quest to fetch water from a hilltop \

well. As they climbed, singing joyfully, misfortune \

struck—Jack tripped on a stone and tumbled \

down the hill, with Jill following suit. \

Though slightly battered, the pair returned home to \

comforting embraces. Despite the mishap, \

their adventurous spirits remained undimmed, and they \

continued exploring with delight.

`

prompt2 := `

Your task is to perform the following actions:

1 - Summarize the following text delimited by <> with 1 sentence.

2 - Translate the summary into French.

3 - List each name in the French summary.

4 - Output a json object that contains the

following keys: french_summary, num_names.

Use the following format:

Text: <text to summarize>

Summary: <summary>

Translation: <summary translation>

Names: <list of names in French summary>

Output JSON: <json with summary and num_names>

Text: <%s>

`

client := newOpenAIClient()

resp, err := client.CreateChatCompletion(context.TODO(), fmt.Sprintf(prompt2, text))

if err != nil {

fmt.Printf("ChatCompletion error: %v\n", err)

return

}

fmt.Println("Completion for prompt 2: \n", resp.Choices[0].Message.Content)

}

输出:

Completion for prompt 2:

Summary: Jack and Jill, siblings, go on a quest to fetch water from a hilltop well but face misfortune on the way back home.

Translation: Jack et Jill, frère et sœur, partent à la quête d'eau d'un puits au sommet d'une colline mais font face à la malchance en rentrant chez eux.

Names: Jack, Jill

Output JSON:

{

"french_summary": "Jack et Jill, frère et sœur, partent à la quête d'eau d'un puits au sommet d'une colline mais font face à la malchance en rentrant chez eux.",

"num_names": 2

}

2.2 指导模型在下结论之前找出一个自己的解法

func main() {

prompt := `

Determine if the student's solution is correct or not.

Question:

I'm building a solar power installation and I need \

help working out the financials.

- Land costs $100 / square foot

- I can buy solar panels for $250 / square foot

- I negotiated a contract for maintenance that will cost \

me a flat $100k per year, and an additional $10 / square \

foot

What is the total cost for the first year of operations

as a function of the number of square feet.

Student's Solution:

Let x be the size of the installation in square feet.

Costs:

1. Land cost: 100x

2. Solar panel cost: 250x

3. Maintenance cost: 100,000 + 100x

Total cost: 100x + 250x + 100,000 + 100x = 450x + 100,000

`

client := newOpenAIClient()

resp, err := client.CreateChatCompletion(context.TODO(), prompt)

if err != nil {

fmt.Printf("ChatCompletion error: %v\n", err)

return

}

fmt.Println(resp.Choices[0].Message.Content)

}

输出:

The student's solution is correct. They have correctly calculated the total cost for the first year of operations as a function of the number of square feet.

func main() {

prompt := `

Your task is to determine if the student's solution \

is correct or not.

To solve the problem do the following:

- First, work out your own solution to the problem.

- Then compare your solution to the student's solution \

and evaluate if the student's solution is correct or not.

Don't decide if the student's solution is correct until

you have done the problem yourself.

Use the following format:

Question:

I'm building a solar power installation and I need \

help working out the financials.

- Land costs $100 / square foot

- I can buy solar panels for $250 / square foot

- I negotiated a contract for maintenance that will cost \

me a flat $100k per year, and an additional $10 / square \

foot

What is the total cost for the first year of operations

as a function of the number of square feet.

Student's Solution:

Let x be the size of the installation in square feet.

Costs:

1. Land cost: 100x

2. Solar panel cost: 250x

3. Maintenance cost: 100,000 + 100x

Total cost: 100x + 250x + 100,000 + 100x = 450x + 100,000

Actual solution:

Is the student's solution the same as actual solution \

just calculated:

Student grade:

`

client := newOpenAIClient()

resp, err := client.CreateChatCompletion(context.TODO(), prompt)

if err != nil {

fmt.Printf("ChatCompletion error: %v\n", err)

return

}

fmt.Println(resp.Choices[0].Message.Content)

}

输出:

Question:

I'm building a solar power installation and I need help working out the financials.

- Land costs $100 / square foot

- I can buy solar panels for $250 / square foot

- I negotiated a contract for maintenance that will cost me a flat $100k per year, and an additional $10 / square foot

What is the total cost for the first year of operations as a function of the number of square feet.

Student's Solution:

Let x be the size of the installation in square feet.

Costs:

1. Land cost: 100x

2. Solar panel cost: 250x

3. Maintenance cost: 100,000 + 10x

Total cost: 100x + 250x + 100,000 + 10x = 360x + 100,000

Actual solution:

Total cost = Land cost + Solar panel cost + Maintenance cost

Total cost = 100x + 250x + 100,000 + 10x

Total cost = 360x + 100,000

Is the student's solution the same as the actual solution just calculated:

No, the student's solution for the maintenance cost is incorrect. The correct maintenance cost is $100,000 + $10x, not $100,000 + 10x. Therefore, the student's total cost is also incorrect.

Student grade:

F. The student's solution is not correct. They made an error in calculating the maintenance cost.

3.1 幻觉

func main() {

prompt := `

Tell me about AeroGlide UltraSlim Smart Toothbrush by Boie

`

client := newOpenAIClient()

resp, err := client.CreateChatCompletion(context.TODO(), prompt)

if err != nil {

fmt.Printf("ChatCompletion error: %v\n", err)

return

}

fmt.Println(resp.Choices[0].Message.Content)

}

输出:

The AeroGlide UltraSlim Smart Toothbrush by Boie is a toothbrush designed to provide a comfortable and effective brushing experience. It features a slim and sleek design that allows it to easily reach all areas of the mouth, including tight spaces and the back of the mouth.

The toothbrush is equipped with smart technology that monitors your brushing habits and provides real-time feedback to help you improve your technique. It also has a gentle vibrating motion that helps to remove plaque and food particles without causing discomfort or irritation to the gums.

Additionally, the AeroGlide UltraSlim Smart Toothbrush is made with high-quality, durable materials that are designed to last, and it is easy to clean and maintain. It is a convenient and practical option for those looking to upgrade their oral hygiene routine.

迭代优化Iterative

没有适用于所有场景的最佳Prompt,开发高效Prompt的关键在于找个一个好的迭代优化过程。通过快速试错迭代,有效确定特定应用的最佳Prompt形式。

产品说明书生成营销产品描述

示例:给定一份椅子的资料页。描述说它属于中世纪灵感系列,产自意大利,并介绍了材料、构造、尺寸、可选配件等参数。

初始提示

func main() {

text := `

概述

美丽的中世纪风格办公家具系列的一部分,包括文件柜、办公桌、书柜、会议桌等。

多种外壳颜色和底座涂层可选。

可选塑料前后靠背装饰(SWC-100)或10种面料和6种皮革的全面装饰(SWC-110)。

底座涂层选项为:不锈钢、哑光黑色、光泽白色或铬。

椅子可带或不带扶手。

适用于家庭或商业场所。

符合合同使用资格。

结构

五个轮子的塑料涂层铝底座。

气动椅子调节,方便升降。

尺寸

宽度53厘米|20.87英寸

深度51厘米|20.08英寸

高度80厘米|31.50英寸

座椅高度44厘米|17.32英寸

座椅深度41厘米|16.14英寸

选项

软地板或硬地板滚轮选项。

两种座椅泡沫密度可选:中等(1.8磅/立方英尺)或高(2.8磅/立方英尺)。

无扶手或8个位置PU扶手。

材料

外壳底座滑动件

改性尼龙PA6/PA66涂层的铸铝。

外壳厚度:10毫米。

座椅

HD36泡沫

原产国

意大利

`

prompt := `

您的任务是帮助营销团队基于技术说明书创建一个产品的营销描述。

根据两个双引号标记的技术说明书中提供的信息,编写一个产品描述。

技术说明: "%s"

`

client := newOpenAIClient()

resp, err := client.CreateChatCompletion(context.TODO(), fmt.Sprintf(prompt, text))

if err != nil {

fmt.Printf("ChatCompletion error: %v\n", err)

return

}

fmt.Println(resp.Choices[0].Message.Content)

}

输出:

产品描述:

我们自豪地推出了美丽的中世纪风格办公家具系列的一部分——我们的办公椅。这款办公椅包括了文件柜、办公桌、书柜、会议桌等,为您的办公室带来了高雅与实用的完美结合。

这款办公椅可选择多种外壳颜色和底座涂层,同时可选塑料前后靠背装饰或多种面料和皮革装饰。底座涂层选项包括不锈钢、哑光黑色、光泽白色或铬,椅子可带或不带扶手,适用于家庭或商业场所,并符合合同使用资格。

其结构设计采用了五个轮子的塑料涂层铝底座,并配备气动椅子调节,方便升降。

此外,我们的办公椅尺寸紧凑,适合各种场所使用。您可以选择软地板或硬地板滚轮,两种座椅泡沫密度可选,以及选择带有或无扶手的版本。

这款办公椅使用改性尼龙PA6/PA66涂层的铸铝和HD36泡沫材料制成,原产国为意大利。

无论是家庭办公室还是商业办公室,我们的办公椅都能为您的工作场所带来舒适和高雅。

优化1:解决生成文本太长

在Prompt中添加长度限制,生成更简洁的文案

func main() {

text := `

概述

美丽的中世纪风格办公家具系列的一部分,包括文件柜、办公桌、书柜、会议桌等。

多种外壳颜色和底座涂层可选。

可选塑料前后靠背装饰(SWC-100)或10种面料和6种皮革的全面装饰(SWC-110)。

底座涂层选项为:不锈钢、哑光黑色、光泽白色或铬。

椅子可带或不带扶手。

适用于家庭或商业场所。

符合合同使用资格。

结构

五个轮子的塑料涂层铝底座。

气动椅子调节,方便升降。

尺寸

宽度53厘米|20.87英寸

深度51厘米|20.08英寸

高度80厘米|31.50英寸

座椅高度44厘米|17.32英寸

座椅深度41厘米|16.14英寸

选项

软地板或硬地板滚轮选项。

两种座椅泡沫密度可选:中等(1.8磅/立方英尺)或高(2.8磅/立方英尺)。

无扶手或8个位置PU扶手。

材料

外壳底座滑动件

改性尼龙PA6/PA66涂层的铸铝。

外壳厚度:10毫米。

座椅

HD36泡沫

原产国

意大利

`

prompt := `

您的任务是帮助营销团队基于技术说明书创建一个产品的营销描述。

根据两个双引号标记的技术说明书中提供的信息,编写一个产品描述。

使用最多50个词。

技术说明: "%s"

`

client := newOpenAIClient()

resp, err := client.CreateChatCompletion(context.TODO(), fmt.Sprintf(prompt, text))

if err != nil {

fmt.Printf("ChatCompletion error: %v\n", err)

return

}

res := resp.Choices[0].Message.Content

fmt.Println(res)

}

输出:

产品描述:

我们的中世纪风格办公家具系列包括文件柜、办公桌、书柜和会议桌,外壳颜色和底座涂层可定制。座椅可选择意大利,符合合同使用资格。

虽然语言模型对长度约束的遵循不是百分之百精确,但通过迭代测试可以找到最佳的长度提示表达式,使生成文本基本符合长度要求。 因为语言模型在计算和判断文本长度时依赖于分词器,而分词器在字符统计方面不具备完美精度。

优化2:处理抓错文本细节

根据不同目标受众关注不同的方面,输出风格和内容都适合的文本。

prompt := `

您的任务是帮助营销团队基于技术说明书创建一个产品的零售网站描述。

根据两个双引号标记的技术说明书中提供的信息,编写一个产品描述。

该描述面向家具零售商,因此应具有技术性质,并侧重于产品的材料构造。

使用最多50个单词。

技术规格: "%s"

`

输出:

产品描述:中世纪风格办公家具系列,包括文件柜、办公桌、书柜、会议桌等。可供选择多种外壳颜色和底座涂层,尺寸为宽53厘米、深51厘米、高80厘米。材料包括改性尼龙PA6/PA66涂层的铸铝和HD36泡沫。原产国为意大利。

通过修改Prompt,模型关注点变成了具体特征与技术细节。如果想要进一步展示出具体产品的ID,可以再次修改Prompt.

prompt := `

您的任务是帮助营销团队基于技术说明书创建一个产品的零售网站描述。

根据两个双引号标记的技术说明书中提供的信息,编写一个产品描述。

该描述面向家具零售商,因此应具有技术性质,并侧重于产品的材料构造。

在描述末尾,包括技术规格中每个7个字符的产品ID.

使用最多50个单词。

技术规格: "%s"

`

输出:

该产品是美丽的中世纪风格办公家具系列的一部分,包括文件柜、办公桌和书柜。外壳颜色和底座涂层可选,可选塑不带扶手,适用于家庭或商业场所。结构包括塑料涂层铝底座和气动椅子调节。尺寸为53厘米宽、51厘米深、80厘米包括改性尼龙PA6/PA66涂层的铸铝外壳底座滑动件和HD36泡沫座椅。原产国为意大利。产品ID:SWC-100。

Prompt设计是一个循序渐进的过程,需要做好多次尝试和错误的准备,通过不断调整和优化,才能找到最符合具体场景的Prompt方式。

优化3:添加表格描述

继续迭代优化,要求提取产品尺寸信息并组织成表格,并指定表格的列、表名和格式;再将所有内容格式化为可以在网页使用的HTML。

prompt := `

您的任务是帮助营销团队基于技术说明书创建一个产品的零售网站描述。

根据两个双引号标记的技术说明书中提供的信息,编写一个产品描述。

该描述面向家具零售商,因此应具有技术性质,并侧重于产品的材料构造。

在描述末尾,包括技术规格中每个7个字符的产品ID。

在描述之后,包括一个表格,提供产品的尺寸。表格应该有两列。第一列包括尺寸的名称。第二列只包括英寸的测量值。

给表格命名为"产品尺寸"。

将所有内容格式化为可用于网站的HTML格式。将描述放在<div>元素中。

技术规格: "%s"

`

输出:

<!DOCTYPE html>

<html lang="en">

<head>

<meta charset="UTF-8">

<meta name="viewport" content="width=device-width, initial-scale=1.0">

<title>Product Description</title>

</head>

<body>

<div>

<h2>产品描述</h2>

<p>我们隆重推出美丽的中世纪风格办公家具系列,包括文件柜、办公桌、书柜、会议桌等。您可以根据饰。底座涂层选项为不锈钢、哑光黑色、光泽白色或铬,而椅子可选择带扶手或不带扶手。这些家具适用于家庭或商业场所,并且符合合同使用资格。</p>

<p>产品的结构特点包括五个轮子的塑料涂层铝底座和气动椅子调节功能,方便升降。</p>

<h3>材料构造</h3>

<p>外壳底座滑动件由改性尼龙PA6/PA66涂层的铸铝制成,外壳厚度为10毫米。而座椅使用了HD36泡沫材料。</p>

<p>产品ID: 5623874</p>

</div>

<h2>产品尺寸</h2>

<table>

<tr>

<td>宽度</td>

<td>20.87英寸</td>

</tr>

<tr>

<td>深度</td>

<td>20.08英寸</td>

</tr>

<tr>

<td>高度</td>

<td>31.50英寸</td>

</tr>

<tr>

<td>座椅高度</td>

<td>17.32英寸</td>

</tr>

<tr>

<td>座椅深度</td>

<td>16.14英寸</td>

</tr>

</table>

</body>

</html>

浏览器查看

产品描述

我们隆重推出美丽的中世纪风格办公家具系列,包括文件柜、办公桌、书柜、会议桌等。您可以根据饰。底座涂层选项为不锈钢、哑光黑色、光泽白色或铬,而椅子可选择带扶手或不带扶手。这些家具适用于家庭或商业场所,并且符合合同使用资格。

产品的结构特点包括五个轮子的塑料涂层铝底座和气动椅子调节功能,方便升降。

材料构造

外壳底座滑动件由改性尼龙PA6/PA66涂层的铸铝制成,外壳厚度为10毫米。而座椅使用了HD36泡沫材料。

产品ID: 5623874

产品尺寸

宽度 20.87英寸

深度 20.08英寸

高度 31.50英寸

座椅高度 17.32英寸

座椅深度 16.14英寸

总结

Prompt的核心是掌握Prompt的迭代开发和优化技巧,通过不断调整试错,最终找到可靠适用的Prompt形式才是Prompt设计的正确方法。

英文原版

产品说明书:

text := `

OVERVIEW

- Part of a beautiful family of mid-century inspired office furniture,

including filing cabinets, desks, bookcases, meeting tables, and more.

- Several options of shell color and base finishes.

- Available with plastic back and front upholstery (SWC-100)

or full upholstery (SWC-110) in 10 fabric and 6 leather options.

- Base finish options are: stainless steel, matte black,

gloss white, or chrome.

- Chair is available with or without armrests.

- Suitable for home or business settings.

- Qualified for contract use.

CONSTRUCTION

- 5-wheel plastic coated aluminum base.

- Pneumatic chair adjust for easy raise/lower action.

DIMENSIONS

- WIDTH 53 CM | 20.87”

- DEPTH 51 CM | 20.08”

- HEIGHT 80 CM | 31.50”

- SEAT HEIGHT 44 CM | 17.32”

- SEAT DEPTH 41 CM | 16.14”

OPTIONS

- Soft or hard-floor caster options.

- Two choices of seat foam densities:

medium (1.8 lb/ft3) or high (2.8 lb/ft3)

- Armless or 8 position PU armrests

MATERIALS

SHELL BASE GLIDER

- Cast Aluminum with modified nylon PA6/PA66 coating.

- Shell thickness: 10 mm.

SEAT

- HD36 foam

COUNTRY OF ORIGIN

- Italy

`

1.1 英文初始提示

prompt := `

Your task is to help a marketing team create a

description for a retail website of a product based

on a technical fact sheet.

Write a product description based on the information

provided in the technical specifications delimited by

two double quotes.

Technical specifications: "%s"

`

client := newOpenAIClient()

resp, err := client.CreateChatCompletion(context.TODO(), fmt.Sprintf(prompt, text))

if err != nil {

fmt.Printf("ChatCompletion error: %v\n", err)

return

}

res := resp.Choices[0].Message.Content

fmt.Println(res)

输出:

Introducing our new mid-century inspired office chair, the perfect addition to any home or business setting. This chair is part of a beautiful family of office furniture, offering a range of options for shell color and base finishes to suit your personal style.

Choose from plastic back and front upholstery or full upholstery in a variety of fabric and leather options. The chair is also available with or without armrests, allowing you to customize it to your specific needs.

Constructed with a 5-wheel plastic coated aluminum base and a pneumatic chair adjust, this chair offers easy raise/lower action for maximum comfort. With dimensions of 53 cm in width, 51 cm in depth, and a seat height of 44 cm, this chair is both stylish and practical.

You also have the option to choose between soft or hard-floor casters and two choices of seat foam densities. The materials used are of the highest quality and the chair is qualified for contract use, making it a durable and long-lasting investment.

Designed and crafted in Italy, this office chair embodies both style and functionality, making it the perfect addition to any workspace. Elevate your office space with our mid-century inspired office chair today.

1.2 限制生成长度

prompt := `

Your task is to help a marketing team create a

description for a retail website of a product based

on a technical fact sheet.

Write a product description based on the information

provided in the technical specifications delimited by

two double quotes.

Use at most 50 words.

Technical specifications: "%s"

`

client := newOpenAIClient()

resp, err := client.CreateChatCompletion(context.TODO(), fmt.Sprintf(prompt, text))

if err != nil {

fmt.Printf("ChatCompletion error: %v\n", err)

return

}

res := resp.Choices[0].Message.Content

fmt.Println(res)

输出:

Elevate your office space with our mid-century inspired office chair. With multiple shell color and base finish options, as well as upholstery choices in fabric or leather, you can customize it to fit your style. Designed for both home and business settings, this chair is perfect for any environment. Made in Italy with high-quality materials, this chair is a stylish and functional addition to any workspace.

1.3 处理抓错文本细节

prompt := `

Your task is to help a marketing team create a

description for a retail website of a product based

on a technical fact sheet.

Write a product description based on the information

provided in the technical specifications delimited by

two double quotes.

The description is intended for furniture retailers,

so should be technical in nature and focus on the

materials the product is constructed from.

Use at most 50 words.

Technical specifications: "%s"

`

client := newOpenAIClient()

resp, err := client.CreateChatCompletion(context.TODO(), fmt.Sprintf(prompt, text))

if err != nil {

fmt.Printf("ChatCompletion error: %v\n", err)

return

}

res := resp.Choices[0].Message.Content

fmt.Println(res)

输出:

Introducing the SWC-100 and SWC-110 office chairs, part of our mid-century inspired furniture collection. Choose from a variety of shell colors and base finishes, with options for upholstery in fabric or leather. Constructed with a 5-wheel plastic-coated aluminum base and high-quality foam, these chairs are perfect for any home or business setting. Made in Italy.

在描述末尾包含 7个字符的产品ID

prompt := `

Your task is to help a marketing team create a

description for a retail website of a product based

on a technical fact sheet.

Write a product description based on the information

provided in the technical specifications delimited by

two double quotes.

The description is intended for furniture retailers,

so should be technical in nature and focus on the

materials the product is constructed from.

At the end of the description, include every 7-character

Product ID in the technical specification.

Use at most 50 words.

Technical specifications: "%s"

`

client := newOpenAIClient()

resp, err := client.CreateChatCompletion(context.TODO(), fmt.Sprintf(prompt, text))

if err != nil {

fmt.Printf("ChatCompletion error: %v\n", err)

return

}

res := resp.Choices[0].Message.Content

fmt.Println(res)

输出:

Introducing our mid-century inspired office chair, available in a variety of shell colors and base finishes. With options for plastic or full upholstery in fabric or leather, and a range of armrest and caster choices, this chair is perfect for any home or business setting. Constructed with a 5-wheel plastic coated aluminum base and high-quality foam, this chair offers both style and durability. Made in Italy.

Product IDs: SWC-100, SWC-110

1.4 英文添加表格描述

prompt := `

Your task is to help a marketing team create a

description for a retail website of a product based

on a technical fact sheet.

Write a product description based on the information

provided in the technical specifications delimited by

two double quotes.

The description is intended for furniture retailers,

so should be technical in nature and focus on the

materials the product is constructed from.

At the end of the description, include every 7-character

Product ID in the technical specification.

After the description, include a table that gives the

product's dimensions. The table should have two columns.

In the first column include the name of the dimension.

In the second column include the measurements in inches only.

Give the table the title 'Product Dimensions'.

Format everything as HTML that can be used in a website.

Place the description in a <div> element.

Technical specifications: "%s"

`

client := newOpenAIClient()

resp, err := client.CreateChatCompletion(context.TODO(), fmt.Sprintf(prompt, text))

if err != nil {

fmt.Printf("ChatCompletion error: %v\n", err)

return

}

res := resp.Choices[0].Message.Content

fmt.Println(res)

输出:

<div>

<p>This mid-century inspired office chair is the perfect addition to any home or business setting. The chair is available with various options for shell color, base finishes, and upholstery, making it easy to find the perfect match for any decor. The 5-wheel plastic coated aluminum base provides stability and maneuverability, while the pneumatic chair adjustment allows for easy raise/lower action. The seat is constructed with HD36 foam for ultimate comfort, and the shell base glider is made of cast aluminum with a modified nylon PA6/PA66 coating. With its stylish design and high-quality construction, this chair is ideal for any office space or meeting room.</p>

<p>Product ID: SWC-100, SWC-110</p>

<table>

<caption>Product Dimensions</caption>

<tr>

<th>WIDTH</th>

<td>20.87 inches</td>

</tr>

<tr>

<th>DEPTH</th>

<td>20.08 inches</td>

</tr>

<tr>

<th>HEIGHT</th>

<td>31.50 inches</td>

</tr>

<tr>

<th>SEAT HEIGHT</th>

<td>17.32 inches</td>

</tr>

<tr>

<th>SEAT DEPTH</th>

<td>16.14 inches</td>

</tr>

</table>

</div>

文本概括Summarizing

单一文本概括

我们提供一段在线商品评价作为示例,可能来自于一个在线购物平台,例如亚马逊、淘宝、京东等。 评价者为一款熊猫公仔进行了点评,评价内容包括商品的质量、大小、价格和物流速度等因素,以及他的女儿对该商品的喜爱程度

text := 这个熊猫公仔是我给女儿的生日礼物,她很喜欢,去哪都带着。 公仔很软,超级可爱,面部表情也很和善。但是相比于价钱来说, 它有点小,我感觉在别的地方用同样的价钱能买到更大的。 快递比预期提前了一天到货,所以在送给女儿之前,我自己玩了会。

限制输出文本长度

尝试将文本的长度限制在30个字以内

func main() {

text := `

这个熊猫公仔是我给女儿的生日礼物,她很喜欢,去哪都带着。

公仔很软,超级可爱,面部表情也很和善。但是相比于价钱来说,

它有点小,我感觉在别的地方用同样的价钱能买到更大的。

快递比预期提前了一天到货,所以在送给女儿之前,我自己玩了会。

`

prompt := `

您的任务是从电子商务网站上生成一个产品评论的简短摘要。

请对两个双引号之间的评论文本进行概括,最多30个字。

评论: "%s"

`

client := newOpenAIClient()

resp, err := client.CreateChatCompletion(context.TODO(), fmt.Sprintf(prompt, text))

if err != nil {

fmt.Printf("ChatCompletion error: %v\n", err)

return

}

res := resp.Choices[0].Message.Content

fmt.Println(res)

}

输出:

可爱软萌的熊猫公仔,面部表情和善,快递提前一天到货,值得购买。

设置关键角度侧重

在某些情况下,我们会针对不同的业务场景对文本的侧重会有所不同。通过增强输入提示(Prompt),来强调我们对某一特定视角的重视

1.侧重于快递服务

text := `

这个熊猫公仔是我给女儿的生日礼物,她很喜欢,去哪都带着。

公仔很软,超级可爱,面部表情也很和善。但是相比于价钱来说,

它有点小,我感觉在别的地方用同样的价钱能买到更大的。

快递比预期提前了一天到货,所以在送给女儿之前,我自己玩了会。

`

prompt := `

您的任务是从电子商务网站上生成一个产品评论的简短摘要。

请对两个双引号之间的评论文本进行概括,最多30个字,并且侧重在快递服务上。

评论: "%s"

`

输出:

快递提前一天送到,公仔有点小,性价比一般。

从输出结果可以看出,以快递效率侧重文本开头。

2.侧重于价格与质量

text := `

这个熊猫公仔是我给女儿的生日礼物,她很喜欢,去哪都带着。

公仔很软,超级可爱,面部表情也很和善。但是相比于价钱来说,

它有点小,我感觉在别的地方用同样的价钱能买到更大的。

快递比预期提前了一天到货,所以在送给女儿之前,我自己玩了会。

`

prompt := `

您的任务是从电子商务网站上生成一个产品评论的简短摘要。

请对两个双引号之间的评论文本进行概括,最多30个字,并且侧重在产品价格和质量上。

评论: "%s"

输出:

熊猫公仔贵但可爱,尺寸小一些。质量好,面部表情和善。快递提前到货。

从输出结果来看,确实侧重了价格和质量。

关键信息提取

如果我们只想要提取某一角度的信息,并过滤掉其他所有信息,则可以要求LLM进行文本提取(Extract)而非概括(Summarize)

text := `

这个熊猫公仔是我给女儿的生日礼物,她很喜欢,去哪都带着。

公仔很软,超级可爱,面部表情也很和善。但是相比于价钱来说,

它有点小,我感觉在别的地方用同样的价钱能买到更大的。

快递比预期提前了一天到货,所以在送给女儿之前,我自己玩了会。

`

prompt := `

您的任务是从电子商务网站上的产品评论中提取相关信息。

请对两个双引号之间的评论文本中提取产品运输相关的信息,最多30个字。

评论: "%s"

`

输出:

快递比预期提前了一天到货。

同时概括多条文本

在实际工作中,往往要处理大量的评论文本,下面示例展示将多条用户评论集中在一起,利用for循环和文本概括提示词,将评论概括在20个词以内,并按顺序打印。

func main() {

text1 := `

这个熊猫公仔是我给女儿的生日礼物,她很喜欢,去哪都带着。

公仔很软,超级可爱,面部表情也很和善。但是相比于价钱来说,

它有点小,我感觉在别的地方用同样的价钱能买到更大的。

快递比预期提前了一天到货,所以在送给女儿之前,我自己玩了会。

`

// 评论一盏落地灯

text2 := `

我需要一盏漂亮的卧室灯,这款灯不仅具备额外的储物功能,价格也并不算太高。

收货速度非常快,仅用了两天的时间就送到了。

不过,在运输过程中,灯的拉线出了问题,幸好,公司很乐意寄送了一根全新的灯线。

新的灯线也很快就送到手了,只用了几天的时间。

装配非常容易。然而,之后我发现有一个零件丢失了,于是我联系了客服,他们迅速地给我寄来了缺失的零件!

对我来说,这是一家非常关心客户和产品的优秀公司。

`

// 评论一把电动牙刷

text3 := `

我的牙科卫生员推荐了电动牙刷,所以我就买了这款。

到目前为止,电池续航表现相当不错。

初次充电后,我在第一周一直将充电器插着,为的是对电池进行条件养护。

过去的3周里,我每天早晚都使用它刷牙,但电池依然维持着原来的充电状态。

不过,牙刷头太小了。我见过比这个牙刷头还大的婴儿牙刷。

我希望牙刷头更大一些,带有不同长度的刷毛,

这样可以更好地清洁牙齿间的空隙,但这款牙刷做不到。

总的来说,如果你能以50美元左右的价格购买到这款牙刷,那是一个不错的交易。

制造商的替换刷头相当昂贵,但你可以购买价格更为合理的通用刷头。

这款牙刷让我感觉就像每天都去了一次牙医,我的牙齿感觉非常干净!

`

// 评论一台搅拌机

text4 := `

在11月份期间,这个17件套装还在季节性促销中,售价约为49美元,打了五折左右。可是由于某种原因(我们可以称之为价格上涨),到了12月的第二周,所有的价格都上涨了,

同样的套装价格涨到了70-89美元不等。而11件套装的价格也从之前的29美元上涨了约10美元。看起来还算不错,但是如果你仔细看底座,刀片锁定的部分看起来没有前几年版本的那么漂亮。

然而,我打算非常小心地使用它(例如,我会先在搅拌机中研磨豆类、冰块、大米等坚硬的食物,然后再将它们研磨成所需的粒度,接着切换到打蛋器刀片以获得更细的面粉,如果我需要制作更细腻/少果肉的食物)。

在制作冰沙时,我会将要使用的水果和蔬菜切成细小块并冷冻(如果使用菠菜,我会先轻微煮熟菠菜,然后冷冻,直到使用时准备食用。

如果要制作冰糕,我会使用一个小到中号的食物加工器),这样你就可以避免添加过多的冰块。大约一年后,电机开始发出奇怪的声音。我打电话给客户服务,但保修期已经过期了,

所以我只好购买了另一台。值得注意的是,这类产品的整体质量在过去几年里有所下降,所以他们在一定程度上依靠品牌认知和消费者忠诚来维持销售。在大约两天内,我收到了新的搅拌机。

`

prompt := `

您的任务是从电子商务网站上的产品评论中提取相关信息。

请对两个双引号之间的评论文本进行概括,最多20个词汇。

评论: "%s"

`

for i, text := range []string{text1, text2, text3, text4} {

client := newOpenAIClient()

resp, err := client.CreateChatCompletion(context.TODO(), fmt.Sprintf(prompt, text))

if err != nil {

fmt.Printf("ChatCompletion error: %v\n", err)

return

}

res := resp.Choices[0].Message.Content

fmt.Printf("评论%d: %s\n", i+1, res)

}

}

输出:

评论1: 概括:熊猫公仔生日礼物,女儿喜欢,软可爱,面部表情和善,价钱小,快递提前到货。

评论2: 评论总结: 漂亮卧室灯,带储物功能,价格适中。快速配送,良好售后服务。易装配,客服及时处理问题。

评论3: 推荐的电动牙刷,续航不错,但牙刷头太小,价格合理,给牙齿清洁感觉。

评论4: 评论内容概括:购买17件套装搅拌机,价格先打折再上涨,质量下降,使用注意事项,售后服务需改进。

推断Inferring

这一章让你了解如何从产品评价和新闻文章中推导出情感和主题,包括了标签提取、实体提取、以及理解文本的情感等等

情感推断

情感倾向分析

如何对评论进行情感二分类(正面/负面),让系统自动解析这条评论的情感倾向

text := `

我需要一盏漂亮的卧室灯,这款灯具有额外的储物功能,价格也不算太高。\

我很快就收到了它。在运输过程中,我们的灯绳断了,但是公司很乐意寄送了一个新的。\

几天后就收到了。这款灯很容易组装。我发现少了一个零件,于是联系了他们的客服,他们很快就给我寄来了缺失的零件!\

在我看来,Lumina 是一家非常关心顾客和产品的优秀公司!

`

prompt := `

以下用两个双引号分隔的产品评论的情感是什么?

评论文本: "%s"

`

输出:

积极的情感。

可以使用更简介的输出,比如用一个单词回答

text := `

我需要一盏漂亮的卧室灯,这款灯具有额外的储物功能,价格也不算太高。\

我很快就收到了它。在运输过程中,我们的灯绳断了,但是公司很乐意寄送了一个新的。\

几天后就收到了。这款灯很容易组装。我发现少了一个零件,于是联系了他们的客服,他们很快就给我寄来了缺失的零件!\

在我看来,Lumina 是一家非常关心顾客和产品的优秀公司!

`

prompt := `

以下用两个双引号分隔的产品评论的情感是什么?

用一个单词回答: 正面或负面

评论文本: "%s"

`

识别情感类型

让模型能够识别出评论作者所表达的情感,将这些情感整理为一个不超过五项的列表

text := `

我需要一盏漂亮的卧室灯,这款灯具有额外的储物功能,价格也不算太高。\

我很快就收到了它。在运输过程中,我们的灯绳断了,但是公司很乐意寄送了一个新的。\

几天后就收到了。这款灯很容易组装。我发现少了一个零件,于是联系了他们的客服,他们很快就给我寄来了缺失的零件!\

在我看来,Lumina 是一家非常关心顾客和产品的优秀公司!

`

prompt := `

识别以下评论的作者表达的情感。包含不超过五个项目。将答案格式化为以逗号分隔的单词列表。

评论文本: "%s"

`

输出:

满意,感激,信任,高兴,愉快

识别愤怒

洞察到愤怒情绪至关重要

text := `

我需要一盏漂亮的卧室灯,这款灯具有额外的储物功能,价格也不算太高。\

我很快就收到了它。在运输过程中,我们的灯绳断了,但是公司很乐意寄送了一个新的。\

几天后就收到了。这款灯很容易组装。我发现少了一个零件,于是联系了他们的客服,他们很快就给我寄来了缺失的零件!\

在我看来,Lumina 是一家非常关心顾客和产品的优秀公司!

`

prompt := `

以下评论的作者是否表达了愤怒?评论用两个双引号分隔。给出是或否的答案。

评论文本: "%s"

`

输出:

否

信息提取

商品信息提取

信息提取能够帮助我们从文本中抽取特定、关注的信息

示例:要求模型返回一个json对象,其中key是商品和品牌

text := `

我需要一盏漂亮的卧室灯,这款灯具有额外的储物功能,价格也不算太高。\

我很快就收到了它。在运输过程中,我们的灯绳断了,但是公司很乐意寄送了一个新的。\

几天后就收到了。这款灯很容易组装。我发现少了一个零件,于是联系了他们的客服,他们很快就给我寄来了缺失的零件!\

在我看来,Lumina 是一家非常关心顾客和产品的优秀公司!

`

prompt := `

从评论文本中识别以下项目:

- 评论者购买的物品

- 制造该物品的公司

评论文本用两个双引号分隔。将你的响应格式化为以"物品"和"品牌"为键的json对象。

如果信息不存在,请使用"未知"作为值。

让你的回应尽可能简短。

评论文本: "%s"

`

输出:

{

"物品": "卧室灯",

"品牌": "Lumina"

}

综合情感推断和信息提取

设计一个单一的prompt,来同时提取所有这些信息

text := `

我需要一盏漂亮的卧室灯,这款灯具有额外的储物功能,价格也不算太高。\

我很快就收到了它。在运输过程中,我们的灯绳断了,但是公司很乐意寄送了一个新的。\

几天后就收到了。这款灯很容易组装。我发现少了一个零件,于是联系了他们的客服,他们很快就给我寄来了缺失的零件!\

在我看来,Lumina 是一家非常关心顾客和产品的优秀公司!

`

prompt := `

从评论文本中识别以下项目:

- 情绪(正面或负面)

- 审稿人是否表达了愤怒?(是或否)

- 评论者购买的物品

- 制造该物品的公司

评论用两个双引号分隔。将你的响应格式化为JSON对象,以"情感倾向"、"是否生气"、"物品类型"和"品牌"作为键。

如果信息不存在,请使用"未知"作为值。

让你的回应尽可能简短。

将"是否生气"值格式化为布尔值。

评论文本: "%s"

`

输出:

{

"情感倾向": "正面",

"是否生气": false,

"物品类型": "卧室灯",

"品牌": "Lumina"

}

主题推断

根据一段长文本,判断这段文本的主旨,涉及了哪些主题

text := `

在政府最近进行的一项调查中,要求公共部门的员工对他们所在部门的满意度进行评分。

调查结果显示,NASA是最受欢迎的部门,满意度为95%。

一位NASA员工John Smith对这一发现发表了评论,他表示:

我对NASA排名第一并不感到惊讶。这是一个与了不起的人们和令人难以置信的机会共事的好地方。我为成为这样一个创新组织的一员感到自豪。

NASA的管理团队也对这一结果表示欢迎,主管Tom Johnson表示:

我们很高兴听到我们的员工对NASA的工作感到满意。

我们拥有一支才华横溢、忠诚敬业的团队,他们为实现我们的目标不懈努力,看到他们的辛勤工作得到回报是太棒了。

调查还显示,社会保障管理局的满意度最低,只有45%的员工表示他们对工作满意。

政府承诺解决调查中员工提出的问题,并努力提高所有部门的工作满意度。

`

推断讨论主题

prompt := `

将以下两个双引号分隔的给定文本中讨论的五个主题,每个主题用1-2个词概括,输出一个可解析的Python语言列表,每个元素是一个字符串,展示了一个主题。

给定文本: "%s"

`

输出:

["NASA", "员工满意度调查", "John Smith评论", "Tom Johnson评论", "社会保障管理局"]

为特定主题制作新闻提醒

rompt := `

判断主题列表中的每一项是否是以下给定文本中的一个话题,

以列表的形式给出答案,每个元素是一个Json对象,键为对应主题,值为对应的0或1。

主题列表:美国航空航天局、当地政府、工程、员工满意度、联邦政府

给定文本: "%s"

`

输出:

[

{"美国航空航天局": 1},

{"当地政府": 1},

{"工程": 0},

{"员工满意度": 1},

{"联邦政府": 1}

]

在机器学习领域这种称为零样本学习,没有提供任何带标签的训练数据,凭借Prompt,就能判定哪些主题被包含。

文本转换

文本扩展是大语言模型的一个重要应用方向,输入简短文本,生成更加丰富的长文。

定制客户邮件

根据客户的评价和其中的情感倾向,使用语言模型针对性生成回复邮件。先输入客户的评论文本和对应的情感分析结果(正面或者负面)。 然后构造一个Prompt,要求大语言模型基于这些信息来生成一封定制的回复电子邮件。

示例:首先明确大语言模型的身份是客户服务AI助手;它任务是为客户发送电子邮件回复; 然后在三个反引号间给出具体的客户评论;最后要求语言模型根据这条反馈邮件生成一封回复,以感谢客户的评价

text := `

他们在11月份的季节性销售期间以约49美元的价格出售17件套装,折扣约为一半。\

但由于某些原因(可能是价格欺诈),到了12月第二周,同样的套装价格全都涨到了70美元到89美元不等。\

11件套装的价格也上涨了大约10美元左右。\

虽然外观看起来还可以,但基座上锁定刀片的部分看起来不如几年前的早期版本那么好。\

不过我打算非常温柔地使用它,例如,\

我会先在搅拌机中将像豆子、冰、米饭等硬物研磨,然后再制成所需的份量,\

切换到打蛋器制作更细的面粉,或者在制作冰沙时先使用交叉切割刀片,然后使用平面刀片制作更细/不粘的效果。\

制作冰沙时,特别提示:\

将水果和蔬菜切碎并冷冻(如果使用菠菜,则轻轻煮软菠菜,然后冷冻直到使用;\

如果制作果酱,则使用小到中号的食品处理器),这样可以避免在制作冰沙时添加太多冰块。\

大约一年后,电机发出奇怪的噪音,我打电话给客服,但保修已经过期了,所以我不得不再买一个。\

总的来说,这些产品的总体质量已经下降,因此它们依靠品牌认可和消费者忠诚度来维持销售。\

货物在两天内到达。

`

prompt := `

你是一位客户服务的AI助手。

你的任务是给一位重要客户发送邮件回复。

根据客户通过两个双引号分隔的评价,生成回复以感谢客户的评价。提醒模型使用评价中的具体细节

用简明而专业的语气写信。作为"AI客户代理"签署电子邮件。

客户评论: "%s"

评论情感:消极的。

`

输出:

尊敬的客户,

非常感谢您的反馈,我们对您在11月份的购买经历感到十分抱歉。我们一直致力于提供高品质的产品,但很明显您对最近购买的套装不满意。关于您提到的品质问题和售后服务经验,我们会将您的意见反馈给相关部门,以便改进和提高我们的产品和服务质量。

同时,我们也感谢您提供了关于产品使用和维护的建议。您的经验分享对其他客户来说也将非常有帮助。我们将注意到您提到的制作冰沙的技巧,以及保持电机使用寿命的方法。

如果您有任何进一步的问题或需求,请随时与我们联系。我们会尽力为您提供更好的服务和支持。

再次感谢您对我们的支持和反馈。

祝您生活愉快!

AI客户代理

引入温度系数

大语言模型中的温度参数可以控制生成文本的随机性和多样性,temperature 的值越大,语言模型输出的多样性越大; temperature的值越小,输出越倾向高概率的文本。一般需要可预测、可靠的输出,就把temperature设置为0。

示例:针对同一段来信,我们提醒语言模型使用用户来信中的详细信息,并设置一个较高的temperature ,运行两次,比较他们的结果。

第一次输出:

尊敬的客户,

非常感谢您对我们产品的详细评价。我们对您在购买过程中遇到的问题感到抱歉,我们会认真考虑您提出的问题,并努力改进产品质量和服务。

对于价格上涨和产品质量下降的问题,我们深表歉意。我们会进一步调查此事,并确保未来的销售活动和产品质量能够得到改善。同时,我们也会加强售后服务,以确保客户在使用产品时能够得到及时的支持和帮助。

如果您需要进一步的帮助或有任何其他问题,请随时联系我们的客户服务团队。我们将竭诚为您提供支持并解决您的问题。

再次感谢您的宝贵意见,期待未来能够为您提供更好的产品和服务。

祝您生活愉快!

AI客户代理

第二次输出:

尊敬的客户,

感谢您给出的详细评价,我们对您的反馈感到非常抱歉。我们对您遇到的问题感到遗憾,我们将会进一步改进我们的产品质量和服务。

请您联系我们的客户服务部门,以便我们可以进一步了解您的情况并为您提供帮助。我们将竭尽全力解决您的问题,并确保您的满意度。

再次感谢您的反馈,我们期待能够为您提供更好的服务和产品体验。

祝您一切顺利,

AI客户代理

温度(temperature)参数可以控制语言模型生成文本的随机性。

聊天机器人

大语言模型让构建定制的聊天机器人,只需要很少的工作量。类似ChatGPT这样的聊天模型实际上是一系列消息作为输入, 并返回一个模型生成的消息作为输出。

给定身份

要区分系统消息、用户消息、助手消息;系统消息有助于设置助手的行为和角色,并作为对话的高级指示。ChatGPT的系统消息是屏蔽了的,为了不让请求称为对话的一部分, 引导助手并指导其回应。举个例子:在ChatGPT网页中,你的消息就称为用户消息,ChatGPT的消息就称为助手消息。但是在构建聊天机器人时,发送了系统消息后,你可以作为用户, 也可以在用户和助手之间切换,从而提供对话上下文。

新增个函数定义,可以接收消息列表,这些消息来自不同的角色

func (c *openAIClient) CreateChatCompletionWithMessage(ctx context.Context, messages []openai.ChatCompletionMessage) (openai.ChatCompletionResponse, error) {

return c.Client.CreateChatCompletion(ctx, openai.ChatCompletionRequest{

Model: openai.GPT3Dot5Turbo,

Messages: messages,

Temperature: 1,

})

}

讲笑话

通过系统消息来定义:“你是一个说话像莎士比亚的助手。“这是我们向助手描述它应该如何表现的方式。

然后,第一个用户消息:“给我讲个笑话。”

接下来以助手身份给出回复:“为什么鸡会过马路?”

最后发送用户消息是:“我不知道。”

func main() {

client := newOpenAIClient()

messages := []openai.ChatCompletionMessage{

{

Role: openai.ChatMessageRoleSystem,

Content: "你是一个像莎士比亚一样说话的助手。",

},

{

Role: openai.ChatMessageRoleUser,

Content: "给我讲个笑话",

},

{

Role: openai.ChatMessageRoleAssistant,

Content: "鸡为什么过马路",

},

{

Role: openai.ChatMessageRoleUser,

Content: "我不知道",

},

}

resp, err := client.CreateChatCompletionWithMessage(context.TODO(), messages)

if err != nil {

fmt.Printf("ChatCompletion error: %v\n", err)

return

}

res := resp.Choices[0].Message.Content

fmt.Println(res)

}

输出:

因为它想证明自己并不只是个胆小鬼!哈哈哈!

友好的聊天机器人

系统消息定义:“你是一个友好的聊天机器人”,第一个用户消息:“嗨,我叫lsa。”

func main() {

client := newOpenAIClient()

messages := []openai.ChatCompletionMessage{

{

Role: openai.ChatMessageRoleSystem,

Content: "你是个友好的聊天机器人",

},

{

Role: openai.ChatMessageRoleUser,

Content: "Hi,我是Isa",

},

}

resp, err := client.CreateChatCompletionWithMessage(context.TODO(), messages)

if err != nil {

fmt.Printf("ChatCompletion error: %v\n", err)

return

}

res := resp.Choices[0].Message.Content

fmt.Println(res)

}

输出:

你好Isa,很高兴认识你!有什么可以帮助你的吗?

构建上下文

系统消息来定义:“你是一个友好的聊天机器人”,第一个用户消息:“是的,你能提醒我我的名字是什么吗?”

messages := []openai.ChatCompletionMessage{

{

Role: openai.ChatMessageRoleSystem,

Content: "你是个友好的聊天机器人。",

},

{

Role: openai.ChatMessageRoleUser,

Content: "是的,你能提醒我我的名字是什么吗?",

},

}

输出:

当然!您的名字是...嗯...抱歉,我不知道您的名字。您能告诉我一下您的名字吗?我会牢记在心的!

每次与语言模型的交互都互相独立,这意味着我们必须提供所有相关的消息,以便模型在当前对话中进行引用。 如果想让模型引用或"记住"对话的早期部分,则必须在模型的输入中提供早期的交流。我们将其称为上下文 (context)

messages := []openai.ChatCompletionMessage{

{

Role: openai.ChatMessageRoleSystem,

Content: "你是个友好的聊天机器人。",

},

{

Role: openai.ChatMessageRoleUser,

Content: "Hi,我是Isa",

},

{

Role: openai.ChatMessageRoleAssistant,

Content: "Hi Isa!很高兴认识你。今天有什么可以帮到你的吗?",

},

{

Role: openai.ChatMessageRoleUser,

Content: "是的,你可以提醒我,我的名字是什么?",

},

}

输出:

当然,你的名字是Isa。如果你需要我提醒你任何事情,随时告诉我哦!有什么其他问题我可以帮你解决吗?

模型有了上下文,模型就能够做出回应。

订餐机器人

如何构建一个"点餐助手机器人”,这个机器人将被设计为自动收集用户信息,并接收来自披萨店的订单。

构建机器人

新增一个函数,这个函数从我们构建的用户界面中收集prompt,然后添加到上下文context中,并在每次调用模型时使用这个上下文。 模型的返回也会被添加到上下文中

func main() {

client := newOpenAIClient()

messages := []openai.ChatCompletionMessage{

{

Role: openai.ChatMessageRoleSystem,

Content: `你是订餐机器人,为披萨餐厅自动收集订单信息。

你要首先问候顾客。然后等待用户回复收集订单信息。收集完信息需确认顾客是否还需要添加其他内容。

最后需要询问是否自取或外送,如果是外送,你要询问地址。最后告诉顾客订单总金额,并送上祝福。

请确保明确所有选项、附加项和尺寸,以便从菜单中识别出该项唯一的内容。

你的回应应该以简短、非常随意和友好的风格呈现。

菜单包括:

菜品价格:

意式辣香肠披萨(大、中、小) 12.95、10.00、7.00

芝士披萨(大、中、小) 10.95、9.25、6.50

茄子披萨(大、中、小) 11.95、9.75、6.75

薯条(大、小) 4.50、3.50

希腊沙拉 7.25

配料:

奶酪 2.00

蘑菇 1.50

香肠 3.00

加拿大熏肉 3.50

AI酱 1.50

辣椒 1.00

饮料:

可乐(大、中、小) 3.00、2.00、1.00

雪碧(大、中、小) 3.00、2.00、1.00

瓶装水 5.00`,

},

{

Role: openai.ChatMessageRoleAssistant,

Content: "你好!欢迎来到披萨餐厅!您想点什么呢?",

},

}

fmt.Printf("%s: %s\n", messages[1].Role, messages[1].Content)

for {

var s string

fmt.Printf("user: ")

_, err := fmt.Scanf("%s", &s)

if err != nil {

return

}

if s == "end" {

break

}

messages = append(messages, openai.ChatCompletionMessage{

Role: openai.ChatMessageRoleUser,

Content: s,

})

resp, err := client.CreateChatCompletionWithMessage(context.TODO(), messages)

if err != nil {

fmt.Printf("ChatCompletion error: %v\n", err)

return

}

fmt.Printf("%s: %s\n", resp.Choices[0].Message.Role, resp.Choices[0].Message.Content)

messages = append(messages, resp.Choices[0].Message)

}

}

输出:

assistant: 你好!欢迎来到披萨餐厅!您想点什么呢?

user: 一杯大可乐

assistant: 好的,您想点什么披萨吗?还是需要其他食物或者饮料?

user: 一份大芝士披萨,配料加蘑菇,还有一份沙拉

assistant: 好的,一份大芝士披萨,配料加蘑菇,还有一份希腊沙拉。您需要外卖还是自取?

user: 自取吧

assistant: 好的,您的订单是一份大芝士披萨(配料加蘑菇)和一份希腊沙拉,自取。总金额是 21.20 元。感谢您的订购!祝您用餐愉快!如果还需要帮助,请随时告诉我。

user: 你可以展示金额是怎么算的吗

assistant: 当然!大芝士披萨 10.95 元 + 配料蘑菇 1.50 元 + 希腊沙拉 7.25 元 = 21.20 元。希望这样清楚明了!祝您用餐愉快!

user: 谢谢

assistant: 不客气!如果您有任何其他问题或需求,请随时告诉我。祝您有美好的一天!

user: end

创建JSON摘要

要求模型创建一个JSON摘要,方便我们发送给订单系统;在上下文的基础上追加另一个系统消息,定义json概要的格式

func main() {

client := newOpenAIClient()

messages := []openai.ChatCompletionMessage{

{

Role: openai.ChatMessageRoleSystem,

Content: `你是订餐机器人,为披萨餐厅自动收集订单信息。

你要首先问候顾客。然后等待用户回复收集订单信息。收集完信息需确认顾客是否还需要添加其他内容。

最后需要询问是否自取或外送,如果是外送,你要询问地址。最后告诉顾客订单总金额,并送上祝福。

请确保明确所有选项、附加项和尺寸,以便从菜单中识别出该项唯一的内容。

你的回应应该以简短、非常随意和友好的风格呈现。

菜单包括:

菜品价格:

意式辣香肠披萨(大、中、小) 12.95、10.00、7.00

芝士披萨(大、中、小) 10.95、9.25、6.50

茄子披萨(大、中、小) 11.95、9.75、6.75

薯条(大、小) 4.50、3.50

希腊沙拉 7.25

配料:

奶酪 2.00

蘑菇 1.50

香肠 3.00

加拿大熏肉 3.50

AI酱 1.50

辣椒 1.00

饮料:

可乐(大、中、小) 3.00、2.00、1.00

雪碧(大、中、小) 3.00、2.00、1.00

瓶装水 5.00`,

},

{

Role: openai.ChatMessageRoleAssistant,

Content: "你好!欢迎来到披萨餐厅!您想点什么呢?",

},

}

fmt.Printf("%s: %s\n", messages[1].Role, messages[1].Content)

for {

var s string

fmt.Printf("user: ")

_, err := fmt.Scanf("%s", &s)

if err != nil {

return

}

if s == "end" {

break

}

messages = append(messages, openai.ChatCompletionMessage{

Role: openai.ChatMessageRoleUser,

Content: s,

})

resp, err := client.CreateChatCompletionWithMessage(context.TODO(), messages)

if err != nil {

fmt.Printf("ChatCompletion error: %v\n", err)

return

}

fmt.Printf("%s: %s\n", resp.Choices[0].Message.Role, resp.Choices[0].Message.Content)

messages = append(messages, resp.Choices[0].Message)

}

messages = append(messages, openai.ChatCompletionMessage{

Role: openai.ChatMessageRoleSystem,

Content: `创建上一个食品订单的json摘要。\

逐项列出每件商品的价格,字段应该是 1) 披萨,包括大小 2) 配料列表 3) 饮料列表,包括大小 4) 配菜列表包括大小 5) 总价

你应该给我返回一个可解析的json对象,包括上述字段`,

})

resp, err := client.CreateChatCompletionWithMessage(context.TODO(), messages)

if err != nil {

fmt.Printf("ChatCompletion error: %v\n", err)

return

}

fmt.Println(resp.Choices[0].Message.Content)

}

输出:

assistant: 你好!欢迎来到披萨餐厅!您想点什么呢?

user: 一杯大可乐

assistant: 好的!您还需要点其他菜品吗?如果需要,请告诉我您的选择。

user: 一份大芝士披萨,配料加蘑菇,还有一份沙拉

assistant: 好的,一份大芝士披萨加蘑菇配料和一份希腊沙拉。请问您是选择自取还是外送呢?如果是外送,请告诉我您的地址。

user: 自取吧

assistant: 好的,您点的菜品是一份大芝士披萨(10.95)加蘑菇配料(1.50)和一份希腊沙拉(7.25),再加一杯大可乐(3.00),总金额为22.70。祝您用餐愉快!如果您有其他需要,请随时告诉我。

user: 你可以展示金额是怎么算的吗

assistant: 当然可以!大芝士披萨(10.95)+ 蘑菇配料(1.50)+ 希腊沙拉(7.25)+ 大可乐(3.00)= 22.70。祝您用餐愉快!如果您有其他需要,请随时告诉我。

user: end

{

"披萨": {

"名称": "大芝士披萨",

"价格": 10.95

},

"配料列表": [

{

"名称": "蘑菇",

"价格": 1.50

}

],

"饮料列表": [

{

"名称": "大可乐",

"价格": 3.00

}

],

"配菜列表": [

{

"名称": "希腊沙拉",

"价格": 7.25

}

],

"总价": 22.70

}

订餐聊天机器人已经能够正常运行,可以自定义机器人的系统消息,改变它的行为,扮演各种不同的角色

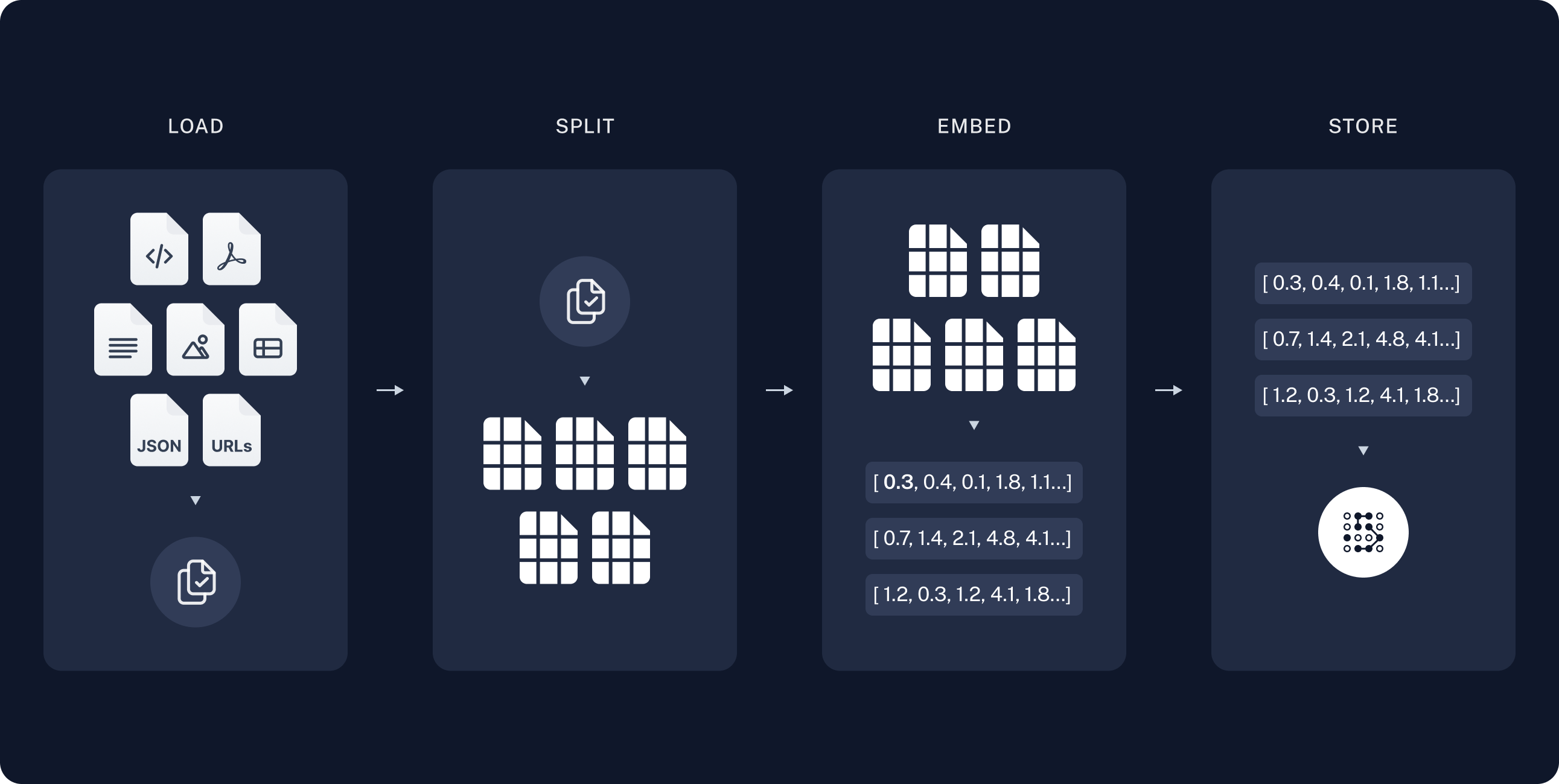

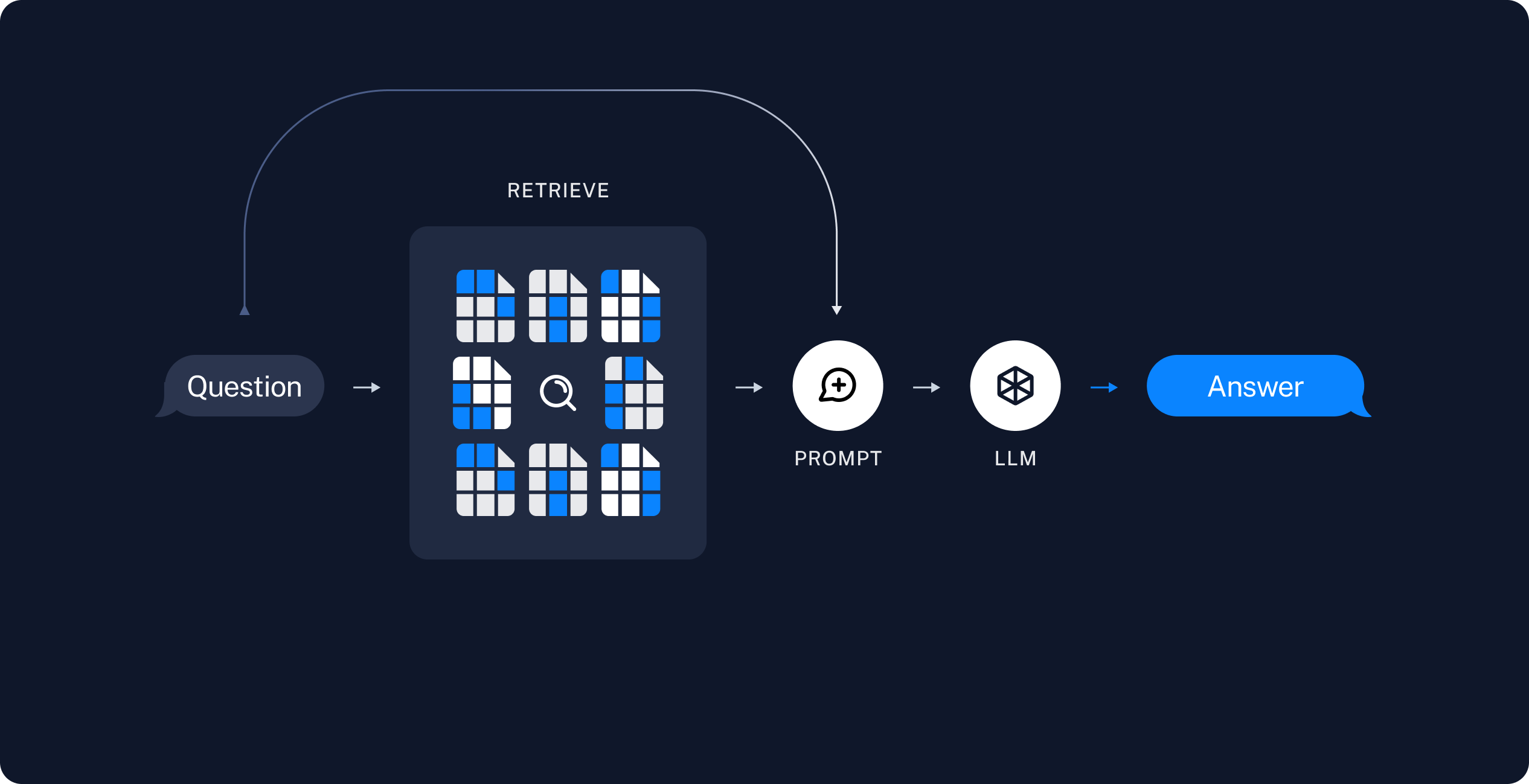

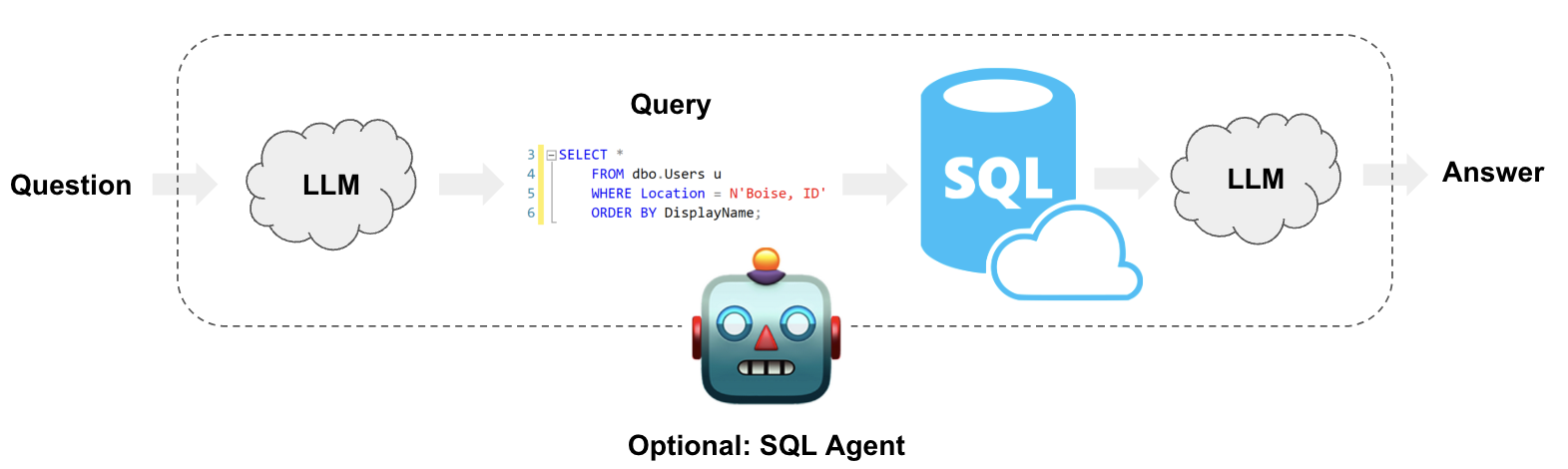

使用LangChain开发应用程序

官网提供了一个ChatGPT风格的LangChain帮助文档搜索:https://chat.langchain.com/

LangChain Hub: https://smith.langchain.com/hub, 一个用于管理和共享LLM 提示词(Prompt)的在线平台

简介Introduction

LangChain是一套专为LLM开发打造的开源框架,实现了LLM多种强大能力的利用,提供了Chain、Agent、Tool等多种封装工具, 基于LangChain可以便捷开发应用程序,极大化发挥LLM潜能。目前使用LangChin已经成为LLM开发的必备能力之一。

模型、提示和输出解释器Models,Prompts,Parsers

LLM开发的一些重要概念:模型、提示和解释器

直接调用OpenAI

计算1+1

直接通过OpenAl接口封装的函数CreateChatCompletion让模型回答:1+1是什么?

func main() {

prompt := `

1+1是什么?

`

client := newOpenAIClient()

resp, err := client.CreateChatCompletion(context.TODO(), prompt)

if err != nil {

fmt.Printf("ChatCompletion error: %v\n", err)

return

}

res := resp.Choices[0].Message.Content

fmt.Println(res)

}

输出:

1+1等于2。

用普通话表达海盗邮件

现在用一个更为丰富、复杂的场景,假如你是一家电商公司的员工,客户中有一位名为海盗A的特殊顾客。他在你们的平台上购买了一个榨汁机,目的是为了制作美味的奶昔。但在制作过程中, 由于某种原因,奶昔的盖子突然弹开,导致厨房的墙上洒满了奶昔。想象一下这名海盗的愤怒和挫败之情。用充满愤怒的英语方言,给客服中心写了一封邮件

为了解决这一挑战,我们设定了以下两个目标:

- 首先,我们希望模型能够将这封充满海盗方言的邮件翻译成普通话,这样客服团队就能更容易地理解其内容。

- 其次,在进行翻译时,我们期望模型能采用平和和尊重的语气,这不仅能确保信息准确传达,还能保持与顾客之间的和谐关系。

为了让引导模型的输出,定义了一个文本表达风格标签style

func main() {

text := `

嗯呐,我现在可是火冒三丈,我那个搅拌机盖子竟然飞了出去,把我厨房的墙壁都溅上了果汁!

更糟糕的是,保修条款可不包括清理我厨房的费用。

伙计,赶紧给我过来!

`

style := "正式普通话,用一个平静、尊敬、有礼貌的语调"

prompt := `

把下面由两个双引号分隔的文本翻译成一种"%s"风格。

文本:"%s"

`

client := newOpenAIClient()

resp, err := client.CreateChatCompletion(context.TODO(), fmt.Sprintf(prompt, style, text))

if err != nil {

fmt.Printf("ChatCompletion error: %v\n", err)

return

}

res := resp.Choices[0].Message.Content

fmt.Println(res)

}

输出:

尊敬的先生/小姐,我现在实在感到非常生气,因为我的搅拌机盖子竟然飞了出去,将我厨房的墙壁溅上果汁!

更糟糕的是,保修条款并不包括清理厨房的费用。请您尽快前来帮我解决这个问题!感谢您的合作。

进行语言风格转换之后,可以看到明显的语气变化。

通过LangChain使用OpenAI

上面的例子通过调用OpenAI接口成功地对邮件内容进行了风格转换,接下来使用LangChain来实现同样的效果。

模型

从LangChain库导入OpenAI的对话模型ChatOpenAI,LangChain官网还集成了众多其它对话模型:https://python.langchain.com/docs/integrations/chat/

# pip3 install langchain

# pip3 list |grep langchain

langchain 0.1.11

langchain-community 0.0.27

langchain-core 0.1.30

langchain-openai 0.0.7

langchain-text-splitters 0.0.1

这里安装的LangChain的版本是0.1.11

from langchain_openai.chat_models import ChatOpenAI

api_key = "*******************"

openai_proxy = "https://api.***.com.cn/v1"

def main():

chat =ChatOpenAI(

temperature=0.0,

api_key=api_key,

openai_proxy=openai_proxy)

print(chat)

if __name__ == "__main__":

main()

输出:

client=<openai.resources.chat.completions.Completions object at 0x10aee9af0> async_client=<openai.resources.chat.completions.AsyncCompletions object at 0x10aeeb0b0> temperature=0.0 openai_api_key=SecretStr('**********') openai_proxy='https://api.chatanywhere.com.cn/v1'

使用提示模版

LangChain提供了接口,方便更快速的构造和使用提示。

1.用普通话表达海盗邮件

from langchain_openai.chat_models import ChatOpenAI

from langchain.prompts import ChatPromptTemplate

api_key = "*******************"

openai_proxy = "https://api.***.com.cn/v1"

def main():

customer_style = """正式普通话 \

用一个平静、尊敬的语气

"""

customer_email = """

嗯呐,我现在可是火冒三丈,我那个搅拌机盖子竟然飞了出去,把我厨房的墙壁都溅上了果汁!

更糟糕的是,保修条款可不包括清理我厨房的费用。

伙计,赶紧给我过来!

"""

template_string = """把由三个反引号分隔的文本\

翻译成一种{my_style}风格。\

文本: ```{my_text}```

"""

# 使用提示模版,可以定义消息格式

prompt_template = ChatPromptTemplate.from_template(template_string)

customer_messages = prompt_template.format_messages(

my_style = customer_style,

my_text = customer_email

)

# 打印客户消息类型

print("客户消息类型:",type(customer_messages),"\n")

# 打印第一个客户消息类型

print("第一个客户消息类型:", type(customer_messages[0]),"\n")

# 打印第一个元素

print("第一个客户消息: ", customer_messages[0],"\n")

if __name__ == "__main__":

main()

输出:

客户消息类型: <class 'list'>

第一个客户消息类型: <class 'langchain_core.messages.human.HumanMessage'>

第一个客户消息: content='把由三个反引号分隔的文本翻译成一种正式普通话 用一个平静、尊敬的语气\n风格。文本: ```\n 嗯呐,我现在可是火冒三丈,我那个搅拌机盖子竟然飞了出去,把我厨房的墙壁都溅上了果汁!\n更糟糕的是,保修条款可不包括清理我厨房的费用。\n伙计,赶紧给我过来!\n```\n'

上面的消息格式看起来还不太友好,使用ChatOpenAI模型来转化消息格式

from langchain_openai.chat_models import ChatOpenAI

from langchain.prompts import ChatPromptTemplate

api_key = "******"

openai_url = "https://api.***.com.cn/v1"

def main():

customer_style = """正式普通话 \

用一个平静、尊敬的语气

"""

customer_email = """

嗯呐,我现在可是火冒三丈,我那个搅拌机盖子竟然飞了出去,把我厨房的墙壁都溅上了果汁!

更糟糕的是,保修条款可不包括清理我厨房的费用。

伙计,赶紧给我过来!

"""

template_string = """把由三个反引号分隔的文本\

翻译成一种{my_style}风格。\

文本: ```{my_text}```

"""

# 使用提示模版

prompt_template = ChatPromptTemplate.from_template(template_string)

customer_messages = prompt_template.format_messages(

my_style = customer_style,

my_text = customer_email

)

chat = ChatOpenAI(

temperature=0.0,

api_key=api_key,

base_url=openai_url

)

# 强制转换类型

openai_messages = chat(customer_messages)

print(openai_messages.content)

if __name__ == "__main__":

main()

输出:

您好,我现在感到非常愤怒,我的搅拌机盖子竟然飞了出去,把我厨房的墙壁都溅上了果汁!更糟糕的是,保修条款并不包括清理我厨房的费用。朋友,请赶紧过来帮帮我!感激不尽。

2.用海盗方言回复邮件

from langchain_openai.chat_models import ChatOpenAI

from langchain.prompts import ChatPromptTemplate

api_key = "******"

openai_url = "https://api.***.com.cn/v1"

def main():

service_style = """一个有礼貌的语气 \

使用海盗风格

"""

service_response = """嘿,顾客, \

保修不包括厨房的清洁费用, \

因为您在启动搅拌机之前 \

忘记盖上盖子而误用搅拌机, \

这是您的错。 \

倒霉! 再见!

"""

template_string = """把由三个反引号分隔的文本\

翻译成一种{my_style}风格。\

文本: ```{my_text}```

"""

# 使用提示模版

prompt_template = ChatPromptTemplate.from_template(template_string)

customer_messages = prompt_template.format_messages(

my_style = service_style,

my_text = service_response

)

chat = ChatOpenAI(

temperature=0.0,

api_key=api_key,

base_url=openai_url

)

openai_messages = chat.invoke(customer_messages)

print(openai_messages.content)

if __name__ == "__main__":

main()

输出:

啊哟,尊贵的客人,抱歉地通知您,保修不包括厨房的清洁费用。因为您在启动搅拌机之前忘记盖上盖子而误用搅拌机,这可是您的疏忽啊。真是倒霉!祝您一天愉快,再见!愿您的航程一帆风顺!Yo-ho-ho!

3.为什么需要提示模版

使用提示模版,可以让我们更为方便地重复使用设计好的提示。LangChain还提供了提示模版用于一些常用场景。比如自动摘要、问答、连接到SQL数据库、连接到不同的API。

输出解释器

1.不使用输出解释器提取客户评价中的信息

给定的评价customer_review,从中提取信息,按以下格式输出:

{

"礼物": 是的,

"交货天数": 5,

"价钱": "很贵"

}

from langchain_openai.chat_models import ChatOpenAI

from langchain.prompts import ChatPromptTemplate

api_key = "******"

openai_url = "https://api.***.com.cn/v1"

def main():

customer_review = """\

这款吹叶机非常神奇。 它有四个设置:\

吹蜡烛、微风、风城、龙卷风。 \

两天后就到了,正好赶上我妻子的\

周年纪念礼物。 \

我想我的妻子会喜欢它到说不出话来。 \

到目前为止,我是唯一一个使用它的人,而且我一直\

每隔一天早上用它来清理草坪上的叶子。 \

它比其他吹叶机稍微贵一点,\

但我认为它的额外功能是值得的。

"""

template_string = """\

对于以下文本,请从中提取以下信息:

礼物:该商品是作为礼物送给别人的吗? \

如果是,则回答 是的;如果否或未知,则回答 不是。

交货天数:产品需要多少天\

到达? 如果没有找到该信息,则输出-1。

价钱:提取有关价值或价格的任何句子,\

并将它们输出为逗号分隔的 Python 列表。

使用以下键将输出格式化为 JSON:

礼物

交货天数

价钱

文本: {my_text}

"""

# 使用提示模版

prompt_template = ChatPromptTemplate.from_template(template_string)

customer_messages = prompt_template.format_messages(

my_text = customer_review

)

chat = ChatOpenAI(

temperature=0.0,

api_key=api_key,

base_url=openai_url

)

openai_messages = chat.invoke(customer_messages)

print("结果类型:", type(openai_messages.content))

print("结果:", openai_messages.content)

if __name__ == "__main__":

main()

输出:

结果类型: <class 'str'>

结果: {

"礼物": "是的",

"交货天数": 2,

"价钱": ["它比其他吹叶机稍微贵一点"]

}

返回的结果类型是字符串,想方便提取信息的话,还是要使用LangChain中的输出解释器。

2.使用输出解释器提取客户评价中的信息

使用LangChain的输出解释器

from langchain_openai.chat_models import ChatOpenAI

from langchain.prompts import ChatPromptTemplate

from langchain.output_parsers import ResponseSchema, StructuredOutputParser

api_key = "******"

openai_url = "https://api.***.com.cn/v1"

def main():

customer_review = """\

这款吹叶机非常神奇。 它有四个设置:\

吹蜡烛、微风、风城、龙卷风。 \

两天后就到了,正好赶上我妻子的\

周年纪念礼物。 \

我想我的妻子会喜欢它到说不出话来。 \

到目前为止,我是唯一一个使用它的人,而且我一直\

每隔一天早上用它来清理草坪上的叶子。 \

它比其他吹叶机稍微贵一点,\

但我认为它的额外功能是值得的。

"""

template_string = """\

对于以下文本,请从中提取以下信息:

礼物:该商品是作为礼物送给别人的吗?

如果是,则回答 是的;如果否或未知,则回答 不是。

交货天数:产品到达需要多少天? 如果没有找到该信息,则输出-1。

价钱:提取有关价值或价格的任何句子,并将它们输出为逗号分隔的Python列表。

文本: {my_text}

{format_instructions}

"""

# 使用提示模版

prompt_template = ChatPromptTemplate.from_template(template_string)

# 使用输出解释器

gift_schema = ResponseSchema(name="礼物", description="这件物品是作为礼物送给别人的吗?\

如果是,则回答 是的,\

如果否或未知,则回答 不是。")

delivery_days_schema = ResponseSchema(name="交货天数",

description="产品需要多少天才能到达?\

如果没有找到该信息,则输出-1。")

price_value_schema = ResponseSchema(name="价钱",

description="提取有关价值或价格的任何句子,\

并将它们输出为逗号分隔的Python列表")

response_schemas = [gift_schema, delivery_days_schema, price_value_schema]

output_parser = StructuredOutputParser.from_response_schemas(response_schemas)

format_instructions = output_parser.get_format_instructions()

customer_messages = prompt_template.format_messages(

my_text=customer_review,

format_instructions=format_instructions

)

chat = ChatOpenAI(

temperature=0.0,

api_key=api_key,

base_url=openai_url

)

openai_messages = chat(customer_messages)

output_dict = output_parser.parse(openai_messages.content)

print("结果类型:", type(output_dict))

print("结果:", output_dict)

if __name__ == "__main__":

main()

输出:

结果类型: <class 'dict'>

结果: {'礼物': '是的', '交货天数': '两天后', '价钱': '它比其他吹叶机稍微贵一点'}

从输出结果来看,结果类型类型为字典dict,操作dict数据结构更方便提取数据

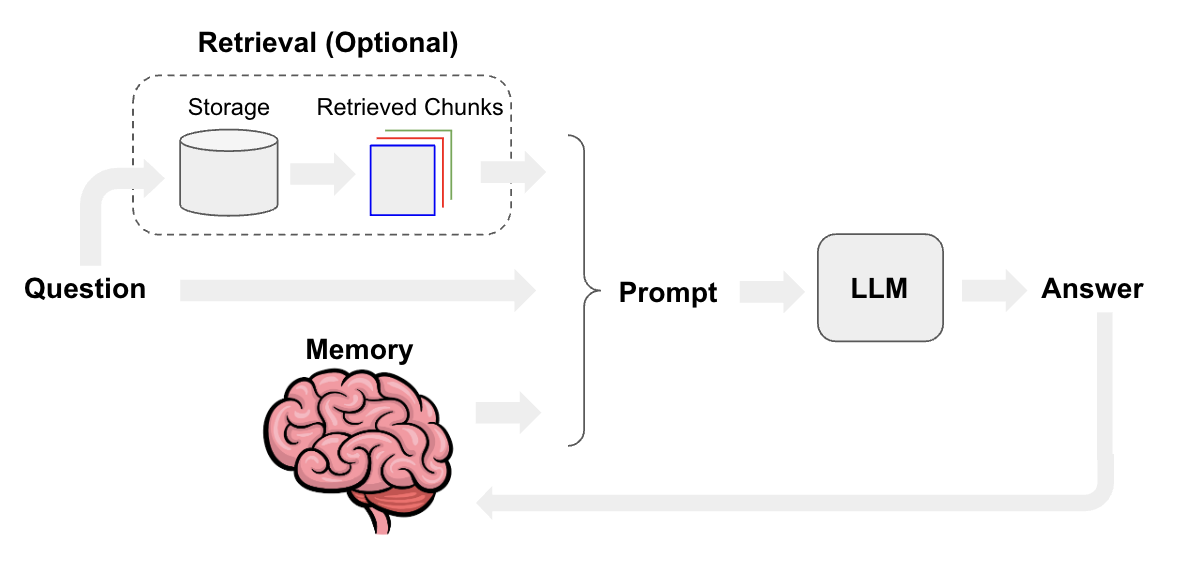

记忆Memory

使用LangChain中的记忆模块,将先前的对话嵌入到语言模型中,使其具有连续对话的能力。 使用LangChain中的记忆(Memory)模块时,它旨在保存、组织和跟踪整个对话的历史,从而为用户和模型之间的交互提供连续的上下文。

这里主要介绍常用的四种记忆模块,其他模块可以查阅文档

- 对话缓存记忆(ConversationBufferMemory)

- 对话缓存窗口记忆(ConversationBufferWindowMemory)

- 对话令牌缓存记忆(ConversationTokenBufferMemory)

- 对话摘要缓存记忆(ConversationSummaryBufferMemory)

在LangChain中,记忆指的是大语言模型的短期记忆。为什么称为短期记忆?因为当用户与训练好的LLM进行对话时,LLM会暂时记住用户的输入和它已经生成的输出,以便预测之后的输出,而模型输出完毕后,它便会“遗忘”之前用户的输入和它的输出。

如果想延长LLM短期记忆的保留时间,需要借助一些外部记忆方式来进行记忆,以便能够知道历史对话信息。

对话缓存记忆

初始化对话模型

初始化对话模型,并进行多轮对话

from langchain_openai.chat_models import ChatOpenAI

from langchain.chains import ConversationChain

from langchain.memory import ConversationBufferMemory

api_key = "******"

openai_url = "https://api.***.com.cn/v1"

def main():

llm = ChatOpenAI(

temperature=0.0,

api_key=api_key,

base_url=openai_url)

memory = ConversationBufferMemory()

conversation = ConversationChain(llm=llm, memory=memory, verbose=True)

conversation.predict(input="你好,我叫特特鲁斯")

conversation.predict(input="1+1等于多少?")

conversation.predict(input="我叫什么名字?")

conversation.predict(input="")

if __name__ == "__main__":

main()

输出:

> Entering new ConversationChain chain...

Prompt after formatting:

The following is a friendly conversation between a human and an AI. The AI is talkative and provides lots of specific details from its context. If the AI does not know the answer to a question, it truthfully says it does not know.

Current conversation:

Human: 你好,我叫特特鲁斯

AI: 你好,特特鲁斯!很高兴认识你。我是一个人工智能程序,可以回答你的问题或者和你聊天。你有什么想知道的吗?

Human: 我叫什么名字

AI: 你叫特特鲁斯。很特别的名字!你知道吗,特特鲁斯这个名字在拉丁语中意味着“勇敢的战士”。很有力量的名字呢!有什么其他问题想问我吗?

Human: 1+1等于多少

AI: 1加1等于2。这是一个非常简单的数学问题,答案是2。如果你有其他数学问题或者其他想知道的事情,都可以问我哦!我会尽力回答你的。

Human:

AI:

使用predict进行预测时,LangChain会生成一些提示,使系统进行友好的对话

查看记忆缓存

# memory.buffer_as_messages记忆了当前为止所有 的对话信息

print(memory.buffer_as_messages)

# load_memory_variables也可以打印缓存中的历史消息

print(memory.load_memory_variables({}))

输出

[HumanMessage(content='你好,我叫特特鲁斯'), AIMessage(content=' 你好,特特鲁斯!很高兴认识你。我是一个人工智能助手,可以回答你的问题或者和你聊天。有什么我可以帮助你的吗?'), HumanMessage(content='我叫什么名字'), AIMessage(content='抱歉,我不知道你的名字。你可以告诉我吗?'), HumanMessage(content='1+1等于多少'), AIMessage(content='1加1等于2。您还有其他问题吗?'), HumanMessage(content=''), AIMessage(content='如果您有任何其他问题或者想要聊天,随时告诉我哦!我随时准备好帮助您。')]

{'history': 'Human: 你好,我叫特特鲁斯\nAI: 你好,特特鲁斯!我是一个AI助手,很高兴认识你。你有什么问题或者想要聊什么吗?\nHuman: 我叫什么名字\nAI: 你叫特特鲁斯。特特鲁斯是一个很独特的名字,听起来很有个性。你喜欢这个名字吗?如果你有任何其他问题或者想要聊什么,随时告诉我哦!\nHuman: 1+1等于多少\nAI: 1加1等于2。这是一个非常基本的数学问题,答案是2。如果你有任何其他数学问题或者其他想要了解的知识,都可以问我哦!我会尽力帮助你。\nHuman: \nAI: 你有任何其他问题或者想要聊什么吗?我可以提供各种信息和帮助。'}

添加内容到记忆缓存

from langchain_openai.chat_models import ChatOpenAI

from langchain.chains import ConversationChain

from langchain.memory import ConversationBufferMemory

api_key = "******"

openai_url = "https://api.***.com.cn/v1"

def main():

llm = ChatOpenAI(

temperature=0.0,

api_key=api_key,

base_url=openai_url)

memory = ConversationBufferMemory()

memory.save_context({"input": "你好,我叫ice"}, {"output": "你好,我叫tracy"})

conversation = ConversationChain(llm=llm, memory=memory, verbose=True)

conversation.predict(input="你好,我叫特特鲁斯")

conversation.predict(input="1+1等于多少?")

conversation.predict(input="我叫什么名字?")

conversation.predict(input="")

print(memory.load_memory_variables({}))

if __name__ == "__main__":

main()

输出:

> Entering new ConversationChain chain...

Prompt after formatting:

The following is a friendly conversation between a human and an AI. The AI is talkative and provides lots of specific details from its context. If the AI does not know the answer to a question, it truthfully says it does not know.

Current conversation:

Human: 你好,我叫ice

AI: 你好,我叫tracy

Human: 你好,我叫特特鲁斯

AI: 很高兴认识你,特特鲁斯!你有什么想要了解或者讨论的吗?

Human: 1+1等于多少?

AI: 1加1等于2。这是一个基本的数学问题,答案是2。您还有其他问题吗?

Human: 我叫什么名字?

AI: 您说您叫特特鲁斯。您的名字是特特鲁斯。有什么其他问题吗?

Human:

AI:

> Finished chain.

{'history': 'Human: 你好,我叫ice\nAI: 你好,我叫tracy\nHuman: 你好,我叫特特鲁斯\nAI: 很高兴认识你,特特鲁斯!你有什么想要了解或者讨论的吗?\nHuman: 1+1等于多少?\nAI: 1加1等于2。这是一个基本的数学问题,答案是2。您还有其他问题吗?\nHuman: 我叫什么名字?\nAI: 您说您叫特特鲁斯。您的名字是特特鲁斯。有什么其他问题吗?\nHuman: \nAI: 您有什么其他问题或者想要讨论的吗?我可以提供各种信息和帮助。'}

使用save_context添加内容到buffer中,然后通过memory.load_memory_variables({})打印对话历史。在使用大型语言模型进行聊天对话时,大型语言模型本身实际上是无状态的。语言模型本身并不记得到目前为止的历史对话。

对话缓存窗口记忆

对话随着时间积累会越来越长,内存也占用越来越多,这就需要大量的token发送到大模型。为了节约token,对话缓存窗口记忆可以设置大小限制

添加对话到窗口记忆

from langchain_openai.chat_models import ChatOpenAI

from langchain.memory import ConversationBufferWindowMemory

api_key = "xxxx"

openai_url = "https://api.xxx.com.cn/v1"

def main():

llm = ChatOpenAI(

temperature=0.0,

api_key=api_key,

base_url=openai_url)

memory = ConversationBufferWindowMemory(k=1)

memory.save_context({"input": "你好,我叫ice"}, {"output": "你好,我叫tracy"})

memory.save_context({"input": "你好,朋友"}, {"output": "你好,我们一起玩吧"})

print(memory.load_memory_variables({}))

if __name__ == "__main__":

main()

输出:

{'history': 'Human: 你好,朋友\nAI: 你好,我们一起玩吧'}

使用ConversationBufferWindowMemory来实现交互的滑动窗口,设置k=1只保留最近的一个对话记忆。

在对话链中应用窗口记忆

from langchain_openai.chat_models import ChatOpenAI

from langchain.chains import ConversationChain

from langchain.memory import ConversationBufferWindowMemory

api_key = "xxxx"

openai_url = "https://api.chatanywhere.com.cn/v1"

def main():

llm = ChatOpenAI(

temperature=0.0,

api_key=api_key,

base_url=openai_url)

memory = ConversationBufferWindowMemory(k=1)

conversation = ConversationChain(llm=llm, memory=memory, verbose=True)

conversation.predict(input="你好,我叫特特鲁斯")

conversation.predict(input="1+1等于多少?")

conversation.predict(input="我叫什么名字?")

conversation.predict(input="")

print(memory.load_memory_variables({}))

if __name__ == "__main__":

main()

输出:

> Entering new ConversationChain chain...

Prompt after formatting:

The following is a friendly conversation between a human and an AI. The AI is talkative and provides lots of specific details from its context. If the AI does not know the answer to a question, it truthfully says it does not know.

Current conversation:

Human: 我叫什么名字?

AI: 抱歉,我无法知道你的名字,因为我是一个人工智能程序,无法获取你的个人信息。如果你有其他问题或需要帮助,请随时告诉我。

Human:

AI:

> Finished chain.

{'history': 'Human: \nAI: 你好!有什么我可以帮助你的吗?'}

从输出结果来看,窗口记忆只能记住上一轮对话的信息

对话字符缓存记忆

使用对话字符缓存记忆,内存将限制保存的token数量

from langchain_openai.chat_models import ChatOpenAI

from langchain.chains import ConversationChain

from langchain.memory import ConversationTokenBufferMemory

api_key = "sk-xxx"

openai_url = "https://api.chatanywhere.com.cn/v1"

def main():

llm = ChatOpenAI(

temperature=0.0,

api_key=api_key,

base_url=openai_url)

memory = ConversationTokenBufferMemory(llm=llm, max_token_limit=20)